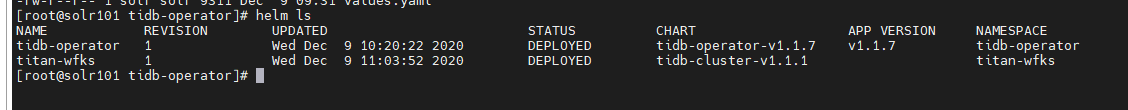

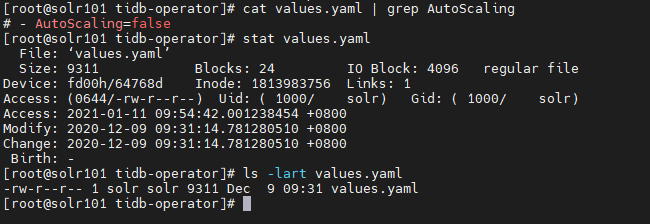

- 麻烦反馈下查询结果 cat values-tidb-operator.yaml | grep AutoScaling

- stat values-tidb-operator.yaml

- ls -lart values-tidb-operator.yaml

- history | grep values-tidb-operator.yaml

这个对象也没有

这个对象也没有

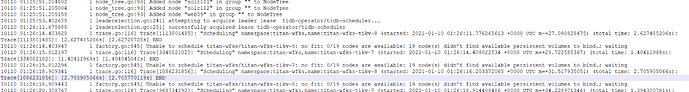

- kubectl get pod -A -o wide

- kubectl logs -n tidb-admin > /xxx/controller.txt

- kubectl logs -n tidb-admin > /xxx/scheduler.txt

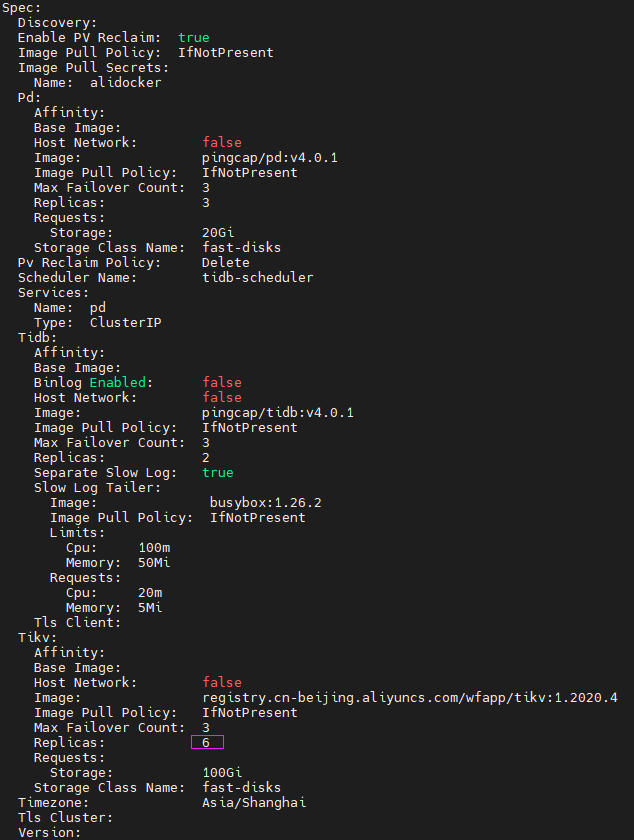

麻烦反馈下集群当前配置和 operator 的日志信息,-n 按照你的名称替换

pod.txt (153.8 KB)

controller.txt.txt (756.9 KB) kube-scheduler.txt.txt (1.4 MB) tidb-scheduler.txt.txt (1.5 KB)

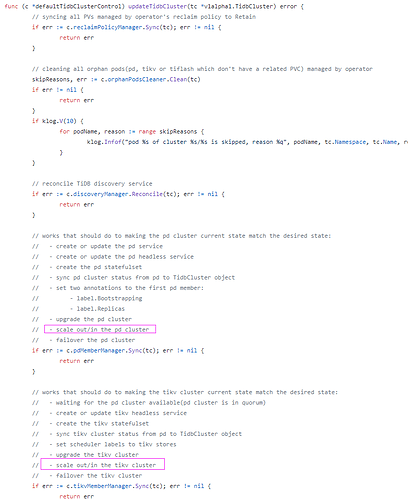

代码写死了吗?

- 麻烦 describe 一下 tikv-7 和 tikv-8 的 信息,多谢。

- kubeclt logs -n xxx tikv-7(8) -c tidb 查看下,多谢。

有进展会尽快反馈,多谢。

没事 我看tidb-operator源码 找到问题了

已经解决了吗? 请问是哪里有问题,麻烦帮忙指出下,多谢。

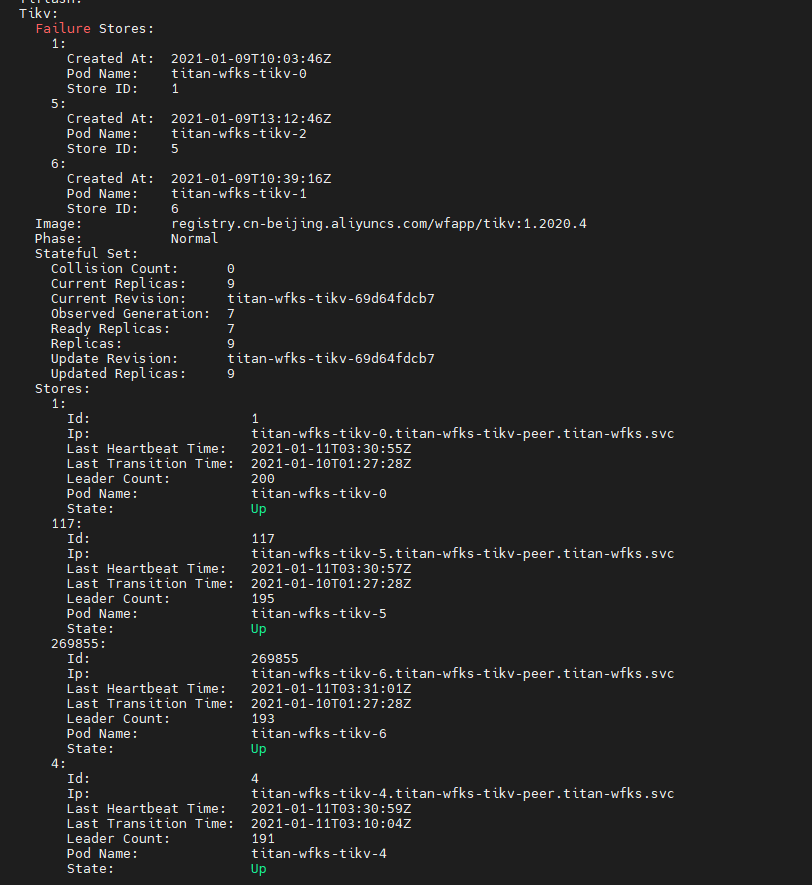

可能是触发了 Failover, 关闭这个功能的话可以重新部署 TiDB Operator, 把 controllerManager.autoFailover 设置成 false, 不过还是要检查下 tikv-0, tikv-1, tikv-2 是出现了什么问题触发了 Failover

@Hacker_zKg8MmGa 方便分享一下问题原因以及解决方案吗?