麻烦贴一下目前 pd-ctl 执行 config show all 的结果以及拿一下pd leader 节点的日志文本文件,日志最好能上传日志文件,截图不便于搜索且信息可能不全

config show all 结果如下

config show all.txt (6.0 KB)

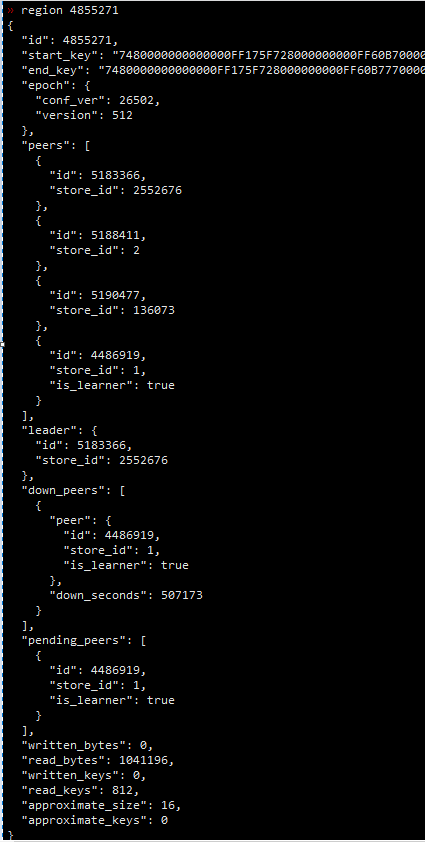

目前只有2个了。结果如下:

» region --jq=“.regions[] | {id: .id, leader_store_id: .leader.store_id | select(.==2552676) }”

{“id”:4855271,“leader_store_id”:2552676}

{“id”:28,“leader_store_id”:2552676}

>> operator add remove-peer 4855271 1

>> operator add remove-peer 28 2

手动执行一下这两个命令,将 两个 pending 的 peer 移除一下看能否正常移除,如果能移除,再观察一下 leader 能不能迁移走

store 1 和 store 2 这两个节点状态是 UP 的吗?

store 1 和 store 2 这2个节点已经是高版本的了

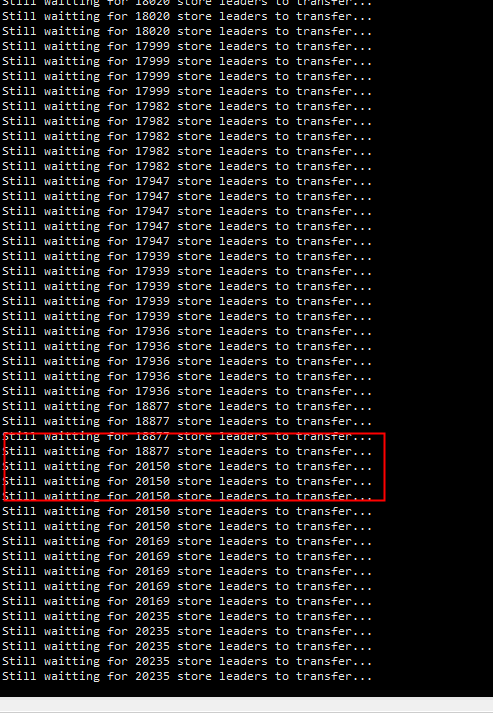

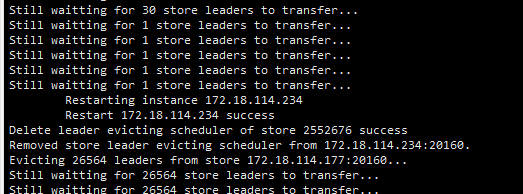

这个kv节点已经ok了,还剩余2个在 transfer

好的,后续 kv 节点遇到剩余 leader 迁移不走的情况,都可以按照这个步骤顺序看下 region 的信息,这边可能是因为 4 个副本影响了 leader 的正常选举。

为什么会是4个副本,能参数配置指定3个副本吗

参数设置的是 3 副本,这个可以通过 max-replica 控制。

出现 4 副本的情况,应该是 region 副本调度过程中产生的中间状态。比如将 region 的一个副本从 store 1 迁移到 store 2 上的时候,会先在 store 2 上创建出一个新的副本,等新副本可用之后,再将 store 1 上的老副本删除掉,中间过程会存在 4 副本的情况。

那下次升级应该还会存在这种问题吧? 4副本的问题还一直存在集群中

正常 4 副本是正常的,这边的有问题是因为一个 peer 既是 down 状态又是 pending 状态

这是一个已知问题,在 tikv 的 repo 上找到了链接:https://github.com/tikv/tikv/issues/5852

对应的 PR 还没有发版:

https://github.com/tikv/tikv/pull/8084

https://github.com/tikv/tikv/issues/8783

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。