升级背景为今天一台tikv磁盘挂了,所以考虑扩容一个tikv,然后下线有问题的这台,目前新增的tikv日志正常,数据在非常缓慢的增长(目前3个多小时,数据量只增长了44G),其他tikv的数据盘大小在800G左右,照这个速度恐怕要到明天,不知道接下来应该如何操作来完成全部扩容操作

tikv 节点应该已加入到集群,可以再检查下 grafana pd 和 tikv 监控是否包括新节点,prometheus 配置文件是否更新。

扩容后数据 balance 慢,可以调大调度 schedule-limit 和 store limit 相关参数,参考 https://docs.pingcap.com/zh/tidb/stable/configure-store-limit#store-limit

监控目前都没有包含新节点

可以 reload 下 prometheus 和 grafana 监控节点

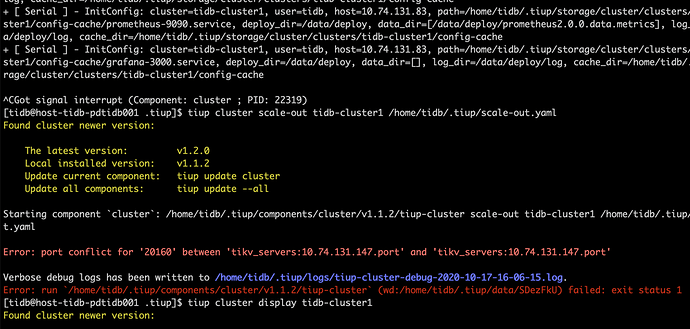

我大概知道扩容卡主的原因了,是因为一个tikv磁盘挂了导致tikv服务挂了,所以连不上,现在reload监控也是,尝试先缩容问题节点,由于数据盘坏了,无法清理数据,现在查看状态会卡在Pending Offline,然后在执行reload grafana操作仍然还会对这个缩容节点有请求操作,导致无响应,无法完成整个操作

手动重启了grafana服务,现在面板上有新的tikv了,不过出问题的这个一直没法下线,估计后面tiup的其他操作也都会卡住

等问题 tikv 上的 region 在其他节点补完,执行 pd-ctl > store delete 后 store 状态会变成 tombstone,然后可以从 tiup 拓扑 meta.yaml 中把这个节点删掉

删除故障节点建议使用 scale-in --force

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。