嗯,应该是这次 rolling update 导致的,不过具体怎么导致的,还不是很清楚。

最后一次 rolling update 有什么报错吗

没有啊,很顺利

也没有人为添加过这个调度么。

目前有两种情况会加上这个调度: 1、rolling update 时候自动添加,正常是升级完一个 tikv 之后自动再删除掉这个调度;如果中途出现了报错,就会有 evict 调度遗留。ps:如果重新 rolling update 成功,最终也会删掉。 2、人为通过 pd-ctl 添加 evict 调度

没有人为加过

那现在看来,是否会有 rolling update 的 bug ?

按说不会,貌似还没有碰到过执行成功之后还残留的问题;也不排除可能某些场景会出现。

版本:3.0.4

集群:3个pd,2个tidb,3个tikv

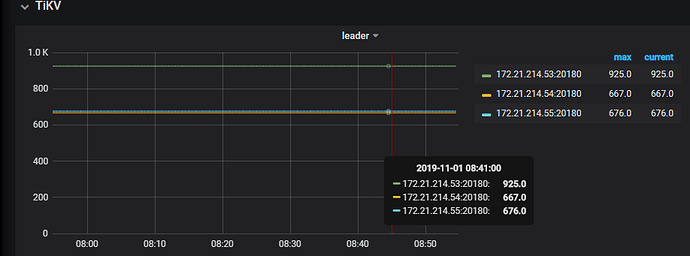

现象:leader分布不均匀

通过pd-ctl 查看权衡值都一样,并且3.0.4里面没有 evict-leader-scheduler-4这个 scheduler 了

resources/bin/pd-ctl store -u http://172.21.214.58:2379 |grep leader_weight

“leader_weight”: 1,

“leader_weight”: 1,

“leader_weight”: 1,

我如何能均衡下leader呢

Leader count 的不均衡不一定代表负载是不均衡的哦。如果一定要调整的话可以通过 leader weight 以及 region weight 进行调整。详细可以参考下官方博客 TiDB 最佳实践的 leader/region 分布不均衡

好的,谢谢

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。