ddmasato

(Ddmasato)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

TiDB 3.1.2

1.9.1 tiup

Go Version: go1.17.7

Git Ref: v1.9.1

GitHash: 8c9d75df55c48e3cd645c2eea1fb0c51cfcd92d0

【概述】场景+问题概述

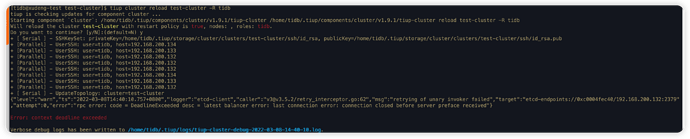

预计升级到 4.0, 按照官方文档导入 tiup, 修改 tidb 参数, oom-action 的行为从 log → cancel

进行 reload 失败, 具体问题如图

【背景】做过哪些操作

tiup cluster edit-config test-cluster

tiup cluster reload test-cluster -R tidb

【现象】业务和数据库现象

【业务影响】

【TiDB 版本】

3.1.2

【附件】

-

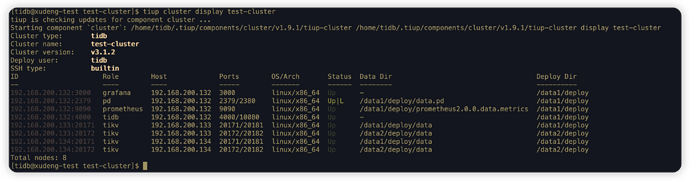

TiUP Cluster Display 信息

-

TiUP Cluster Edit Config 信息

-

TiDB- Overview 监控

数据小黑

(数据小黑)

3

tiup cluster display cluster-id看一下pd状态正常么?

ddmasato

(Ddmasato)

4

hi,在中控机上,验证过,可以使用 tidb 账号登录 对应服务器,应该不是这个问题.

数据小黑

(数据小黑)

6

这个问题没遇到过,感觉上pd上的那个etcd不正常,能不能不区分角色reloa甚至于重启一下?尝试看看问题能不能绕过去?

ddmasato

(Ddmasato)

7

额,做过如下操作:

- 不加角色进行 reload, 报错依旧~~

- tiup cluster stop\start 集群, 去 tidb\config 目录,查看配置未更改

绕过去指的啥? 有相应文档参考嘛…

未来通过 edit 修改配置, 如何推送到相应组件呢?

数据小黑

(数据小黑)

8

麻烦贴一下,刚才那个reload的日志和pd、tidb的日志吧,看看能不能分析一下原因

1 个赞

ddmasato

(Ddmasato)

9

感谢 !!!

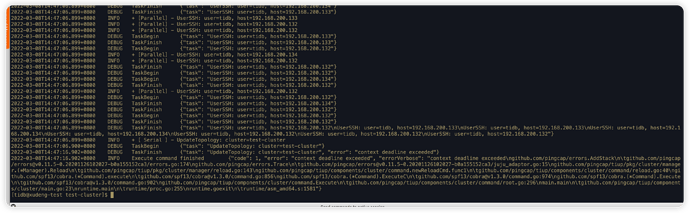

这是 reload 产生的 debug 日志:tiup-cluster-debug-2022-03-08-15-32-45.log (8.4 KB)

pd 组件在操作 reload 之前清空了, 执行了 reload以后未产生日志…

tidb 组件产生了如下日志:

[tidb@node1 log]$ cat tidb.log

[2022/03/08 15:32:31.066 +08:00] [INFO] [gc_worker.go:243] ["[gc worker] there's already a gc job running, skipped"] ["leaderTick on"=5fda100b92c000a]

[2022/03/08 15:32:41.646 +08:00] [INFO] [conn.go:489] ["wait handshake response fail due to connection has be closed by client-side"] [conn=110]

[2022/03/08 15:33:11.189 +08:00] [INFO] [gc_worker.go:580] ["[gc worker] start delete"] [uuid=5fda100b92c000a] [ranges=0]

[2022/03/08 15:33:11.189 +08:00] [INFO] [gc_worker.go:599] ["[gc worker] finish delete ranges"] [uuid=5fda100b92c000a] ["num of ranges"=0] ["cost time"=366ns]

[2022/03/08 15:33:11.190 +08:00] [INFO] [gc_worker.go:622] ["[gc worker] start redo-delete ranges"] [uuid=5fda100b92c000a] ["num of ranges"=0]

[2022/03/08 15:33:11.190 +08:00] [INFO] [gc_worker.go:641] ["[gc worker] finish redo-delete ranges"] [uuid=5fda100b92c000a] ["num of ranges"=0] ["cost time"=371ns]

[2022/03/08 15:33:11.191 +08:00] [INFO] [gc_worker.go:975] ["[gc worker] sent safe point to PD"] [uuid=5fda100b92c000a] ["safe point"=431678840120803328]