为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【概述】 场景 + 问题概述

【背景】 做过哪些操作

【问题】 当前遇到的问题

【业务影响】

【TiDB 版本】

【应用软件及版本】

【附件】 相关日志及配置信息

TiUP Cluster Display 信息

TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/ )

TiDB-Overview Grafana监控

TiDB Grafana 监控

TiKV Grafana 监控

PD Grafana 监控

对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查 类问题,请下载脚本 运行。终端输出的打印结果,请务必全选 并复制粘贴上传。

1 个赞

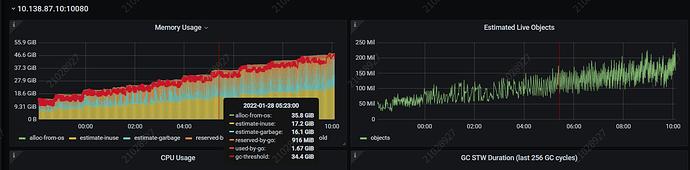

建议在Grafana中查看runtime面板中的监控,看一看具体内存使用情况

2 个赞

啦啦啦啦啦

2022 年1 月 26 日 03:26

6

排查下是否有慢sql或者没执行完的expensive sql导致内存上升

2 个赞

现在还没有对外承接业务,所有当前是没有业务查询的,只会定时的将大数据的报表数据批量写入。通过runtime 查看内容的占用如下。

1 个赞

请求是均衡的, 采用的轮询的均衡规则。 这个是对nginx 的access.log 做的请求统计。

1 个赞

疾风之狼

2022 年2 月 5 日 01:40

9

批量插入数据,是一个连接执行的吧,负载均衡一般是同一个Session的请求都是发给同一个服务器的。而且你这个批量插入数据是一个大事务,因此导致你的一个服务器的内存占用很大,其它两个就当吃瓜群众了。

疾风之狼

2022 年2 月 5 日 01:44

10

一个服务器占用内存大了之后,你把杀掉了,那么后续连接请求就会连到另外一个TiDB Server,因此在你看来,每个Server貌似都有请求,且符合轮询的负载规则,但实际上在同一个时刻,各个服务器的请求并不是均衡的,如果可以的话,可以把这个大批量插入分成若干个小事务插入会更好。

在负载均衡上将内存持续上升的tidb-server 节点去掉, 观察一该tidb-server 的内存情况,tidb-server 内存还是在继续升高。

[2022/02/09 13:27:59.064 +08:00] [INFO] [coprocessor.go:812] ["[TIME_COP_PROCESS] resp_time:13.770061451s txnStartTS:431064858892697603 region_id:52161 store_addr:10.138.87.8:20160 kv_process_ms:12414 kv_wait_ms:1 kv_read_ms:0 processed_versions:84085 total_versions:86185 rocksdb_delete_skipped_count:1679 rocksdb_key_skipped_count:172986 rocksdb_cache_hit_count:65 rocksdb_read_count:1492 rocksdb_read_byte:30682540"]

该tidb-server 的慢日志打印的sql 如下:

1 个赞

system

2022 年10 月 31 日 19:09

12

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。