为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:

Release Version: v2.1.13

Git Commit Hash: 6b5b1a6802f9b8f5a22d8aab24ac80729331e1bc

Git Branch: HEAD

UTC Build Time: 2019-06-21 12:27:08

GoVersion: go version go1.12 linux/amd64

Race Enabled: false

TiKV Min Version: 2.1.0-alpha.1-ff3dd160846b7d1aed9079c389fc188f7f5ea13e

Check Table Before Drop: false - 【问题描述】:

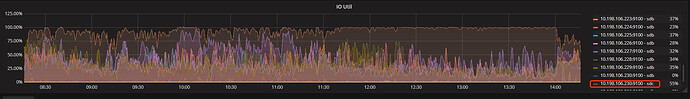

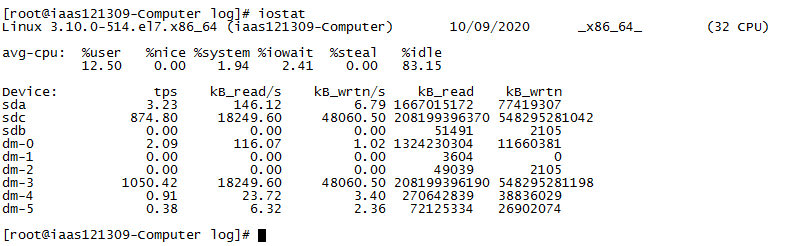

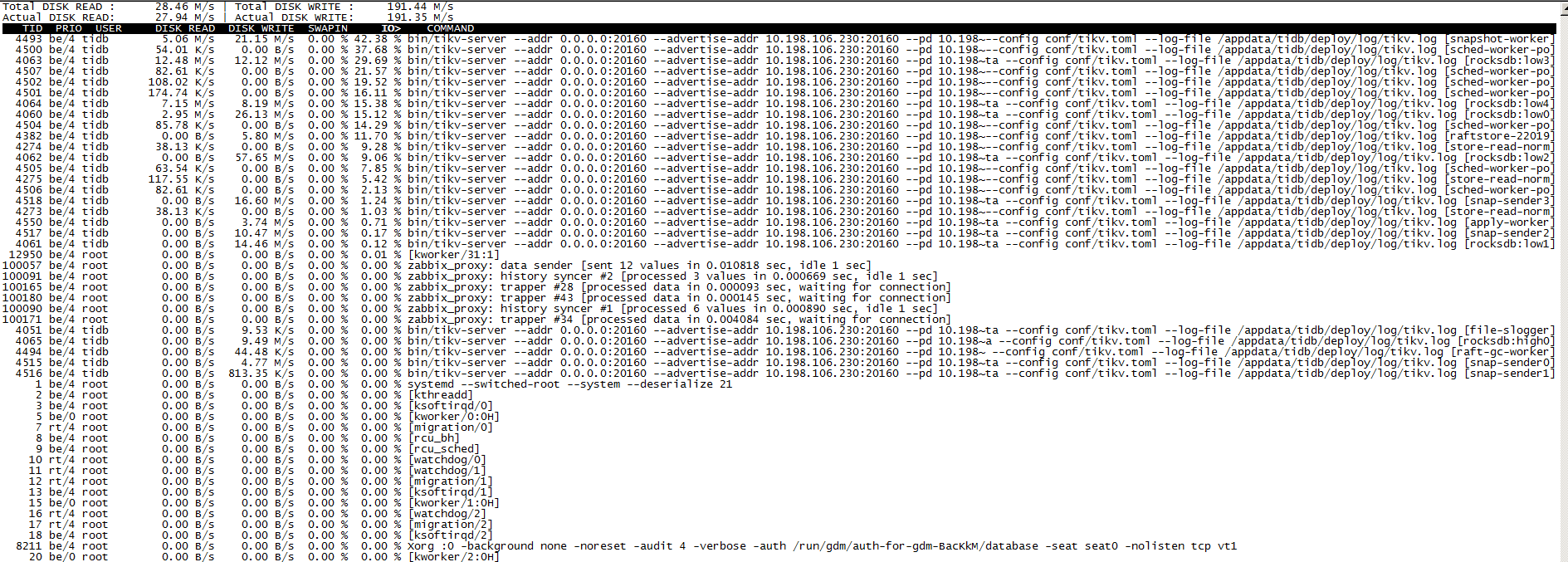

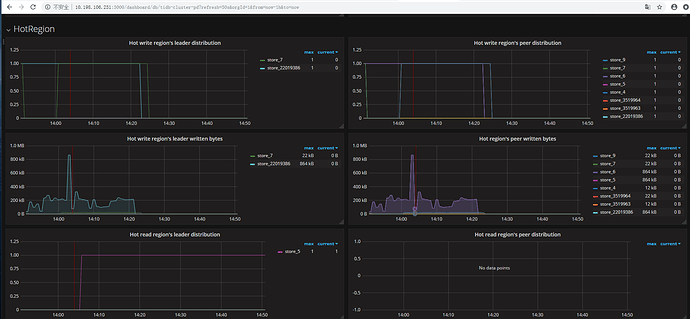

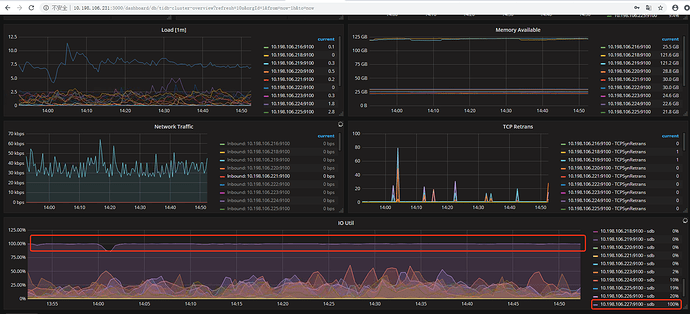

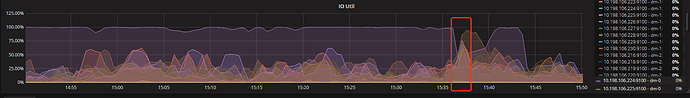

整个集群8个tikv节点总有一个tikv节点io util占用明显很高,甚至达到100%,导致业务处理较慢,请问如何排查问题和解决,或者通过调度等手段尽快让该节点IO降低?

部分截图如下:

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出打印结果,请务必全选并复制粘贴上传。