集群由4.0.4升级到4.0.5时,TiDB升级失败,手动启动时提示缺少TiDB.toml的配置文件。

- 使用的 tiup 还是 ansible ? 应该是 tiup 部署对吗?

- 手工启动是在 tidb 目标服务器的deploy/tidb-4000/scripts 执行了 run_tidb.sh 吗? 那麻烦反馈下 run_tidb.sh 的信息, 并且坚持下 conf 目录下 tidb.toml 文件是否存在,如果存在也反馈下文件内容,多谢。

- 使用的是tiup升级的。

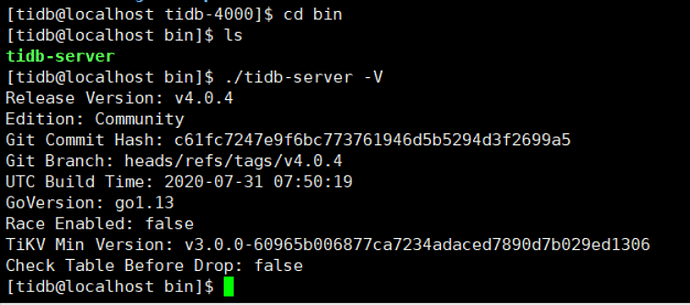

- 我使用的不是run_tidb.sh启动的,使用的是下面的命令启动的:

bin/tidb-server -P 4000 --status=10080 --host=0.0.0.0 --advertise-address=xxx.xxx.xxx.xxx --store=tikv --config=conf/tidb.toml --path=xxx.xxx.xxx.xxx:2379,xxx.xxx.xxx.xxx:2379,xxx.xxx.xxx.xxx:2379 --log-slow-query=log/tidb_slow_query.log --config=conf/tidb.toml --log-file=/ssd/tidb/deploy/log/tidb.log

我的情况是在升级的过程中升级了一台就中断了。tidb.toml文件确实不存在了。我从另外一台机器上copy过来后启动的。

这个升级过程是不是没有升级完成?我界面上显示都是4.0.5的版本了。

我也遇到过,感觉tiup cluster v1.1.0版本不太稳定有bug(执行tiup cluster reload uat-coo-tidb -R tidb时会删除/data/tidb/deploy/conf/tidb.toml配置文件),切换为v1.0.9正常

我也遇到了,提示超时,手动启动pd提示缺少 pd.toml 文件

- [ Serial ] - UpgradeCluster

Restarting component tiflash

Restarting instance 10.10.5.30

Restart 10.10.5.30 success

Restarting instance 10.10.5.31

Restart 10.10.5.31 success

Restarting instance 10.10.5.32

Restart 10.10.5.32 success

Restarting component pd

Restarting instance 10.10.5.29

Restart 10.10.5.29 success

Restarting instance 10.10.5.28

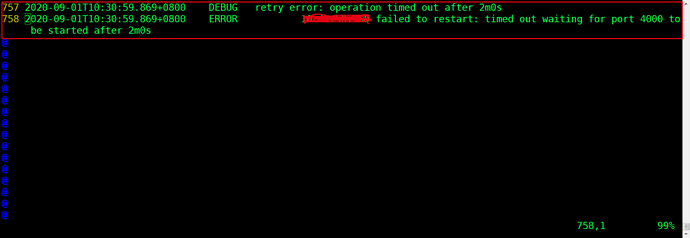

retry error: operation timed out after 2m0s

10.10.5.28 failed to restart: timed out waiting for port 2379 to be started after 2m0s

Error: 10.10.5.28 failed to restart: timed out waiting for port 2379 to be started after 2m0s: timed out waiting for port 2379 to be started after 2m0s

Verbose debug logs has been written to /data1/deploy/logs/tiup-cluster-debug-2020-09-01-16-20-51.log.

Error: run /home/tidb/.tiup/components/cluster/v1.1.0/tiup-cluster (wd:/home/tidb/.tiup/data/S9K3zdD) failed: exit status 1

- tiup是1.1.0的版本。

- 信息:

Starting componentcluster: /home/tidb/.tiup/components/cluster/v1.1.0/tiup-cluster display cdel-yunqi

tidb Cluster: cdel-yunqi

tidb Version: v4.0.4

ID Role Host Ports OS/Arch Status Data Dir Deploy Dir

10.42.50.159:9093 alertmanager 10.42.50.159 9093/9094 linux/x86_64 Up /ssd/tidb/deploy/data.alertmanager /ssd/tidb/deploy

10.42.50.159:3000 grafana 10.42.50.159 3000 linux/x86_64 Up - /ssd/tidb/deploy

10.42.50.161:2379 pd 10.42.50.161 2379/2380 linux/x86_64 Up /ssd/tidb/deploy/data.pd /ssd/tidb/deploy

10.42.50.187:2379 pd 10.42.50.187 2379/2380 linux/x86_64 Up /ssd/tidb/deploy/data.pd /ssd/tidb/deploy

10.42.50.188:2379 pd 10.42.50.188 2379/2380 linux/x86_64 Up|L|UI /ssd/tidb/deploy/data.pd /ssd/tidb/deploy

10.42.50.159:9090 prometheus 10.42.50.159 9090 linux/x86_64 Up /ssd/tidb/deploy/prometheus2.0.0.data.metrics /ssd/tidb/deploy

10.42.50.159:4000 tidb 10.42.50.159 4000/10080 linux/x86_64 Up - /ssd/tidb/deploy

10.42.50.160:4000 tidb 10.42.50.160 4000/10080 linux/x86_64 Up - /ssd/tidb/deploy

10.42.50.159:9000 tiflash 10.42.50.159 9000/8123/3930/20170/20292/8234 linux/x86_64 Up data /ssd/tidb/deploy_flash/

10.42.50.160:9000 tiflash 10.42.50.160 9000/8123/3930/20170/20292/8234 linux/x86_64 Up data /ssd/tidb/deploy_flash/

10.42.50.189:20160 tikv 10.42.50.189 20160/20180 linux/x86_64 Up /ssd/tidb/deploy/data /ssd/tidb/deploy

10.42.50.190:20160 tikv 10.42.50.190 20160/20180 linux/x86_64 Up /ssd/tidb/deploy/data /ssd/tidb/deploy

10.42.50.191:20160 tikv 10.42.50.191 20160/20180 linux/x86_64 Up /ssd/tidb/deploy/data /ssd/tidb/deploy

10.42.50.192:20160 tikv 10.42.50.192 20160/20180 linux/x86_64 Up /ssd/tidb/deploy/data /ssd/tidb/deploy

10.42.50.193:20160 tikv 10.42.50.193 20160/20180 linux/x86_64 Up /ssd/tidb/deploy/data /ssd/tidb/deploy

真的是tiup cluster 1.1.0引起的问题,用1.0.9能够成功升级。

好吧

我也用 1.0.9 升级成功了

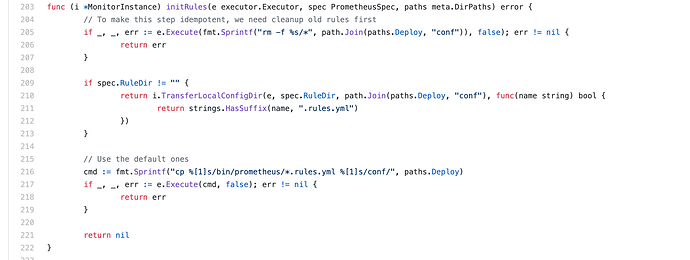

十分抱歉,确实是 v1.1.0 引入的 bug:https://github.com/pingcap/tiup/issues/736,目前从 ansible import 的集群收到影响

今晚会修复发布

已发布 v1.1.1

收到,谢谢!

![]()

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。