最近涉及到数据中心的搬迁,所以打算等搬迁完成后再升级到3.0

这两天查询资料,参阅帖子与这个类似,业务无读写情况下,tikv负载仍然很高,磁盘IO也几乎达到瓶颈 - #2,来自 Kay-PingCAP

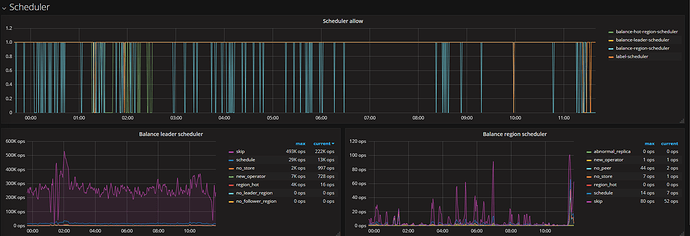

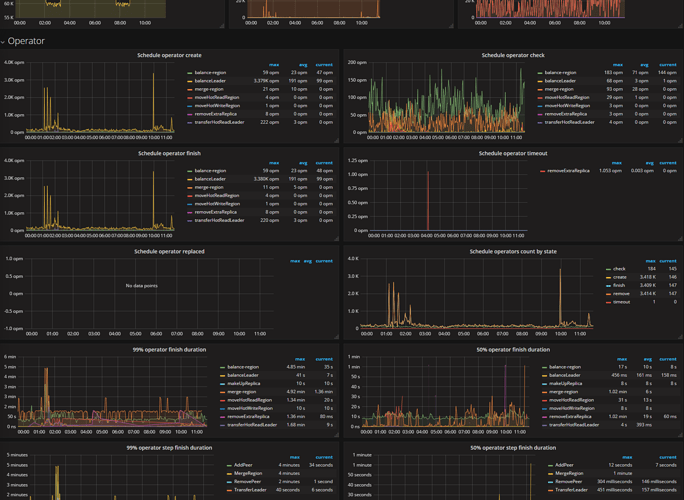

初步判断是因为region的调度导致。开启了region merge后,才出现的这个情况,但是上面的帖子是region到一定的程度后就恢复了,我的案例设置的如下参数

"max-merge-region-size": 50

"merge-schedule-limit": 6

"max-merge-region-keys":2000

目前也已经关闭。将"max-merge-region-size": 设置为0

但是region还在持续调度。。。。持续TIKV的磁盘高I/O,硬盘出问题的概率也很大,这个要怎么去优化,调整pd的设置?

目前的配置:

» config show

{

"max-snapshot-count": 3,

"max-pending-peer-count": 0,

"max-merge-region-size": 0,

"max-store-down-time": "30m0s",

"leader-schedule-limit": 6,

"region-schedule-limit": 6,

"replica-schedule-limit": 4,

"merge-schedule-limit": 6,

"tolerant-size-ratio": 2.5,

"schedulers-v2": [

{

"type": "balance-region",

"args": null

},

{

"type": "balance-leader",

"args": null

},

{

"type": "hot-region",

"args": null

},

{

"type": "label",

"args": null

}

]

}