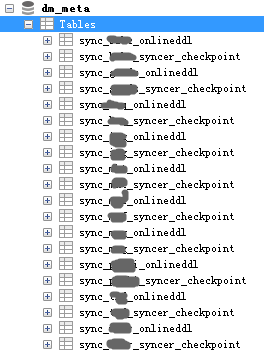

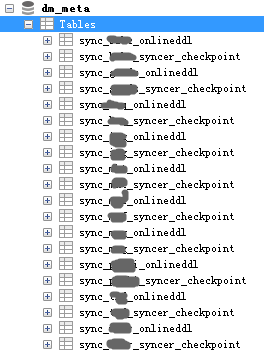

我这边需求是想要备份中包含如图中这些syncer_checkpoint中的mysql binlog信息,这样如果某一个schema DM同步出现丢数据或者其它异常导致tidb无法使用,可以恢复备份,然后从syncer_checkpoint中的位点开启同步。在br工具中不知是否可以实现?

我这边需求是想要备份中包含如图中这些syncer_checkpoint中的mysql binlog信息,这样如果某一个schema DM同步出现丢数据或者其它异常导致tidb无法使用,可以恢复备份,然后从syncer_checkpoint中的位点开启同步。在br工具中不知是否可以实现?

Hi,感谢建议。目前 Coprocessor 算子其实非常 TiDB Specific,还包括 TiDB 特有的 Key 格式解码等等。如果是为了让 TiKV 上层非 TiDB 应用工作效率更高的话,实现 Coprocessor 插件机制是否能更好地满足需求?

Hi, 3.0 版本起的 TiDB, PD, TiKV 组件均遵循统一的日志格式(具体格式 spec 在这里),这个日志格式有遇到什么问题吗?

Hi,从慢日志设计来说 pt-query-digest 是支持分析 TiDB 慢日志的(文档),这个是否已经能满足需求了呢

个人感觉插件机制是作为一个补充手段,bson和pb格式作为一个非常通用的二进制序列化格式,我认为作为内置支持是有必要的。这在未来也可以拓展出更多的功能。例如用于优化tidb的json函数支持。当然,插件机制也是完全可以满足实现非关系型数据库的需求的,只是在部署上会比内置支持稍显不便。

这两个格式指的是 TiKV Coprocessor 对外回传的数据格式,还是 TiKV 解析 Row Value 时候希望的 Row Value 的格式呢?如果指是 Row Value 的话,Row Key 是否满足 TiDB 行编码方案 tXXXXXXXX_rXXXXXXXXYYYYYYYY 的格式呢?如果 Key 格式不满足的话,仅仅 Row Value 支持 bson / pb 解码是不足以支撑 TiKV 上非 TiDB 应用的下推计算需求的。

具体 Coprocessor 的处理逻辑解析可以参见源码阅读文章:

关于 Coprocessor 支持的 Value 格式(的其中最新的一种):

关于 Coprocessor 支持的 Key 格式:

1.TiKV支持多磁盘

现在TiKV不支持直接使用多块磁盘,容易造成磁盘浪费

2.TiKV使用更多的CPU

3.TiDB完全兼容MySQL DDL

现在TiDB不完全兼容MySQL DDL,导致Syncer同步MySQL数据经常报错

4.TiDB支持UDF UDAF UDTF

提高TiDB易用性

5.TiDB OOM发出报警

TiDB更多关键信息支持报警指的是解析Row Value的格式。Row Key不能完全满足TiDB的编码格式,非关系数据库的数据组织结构与TiDB并不相似。 如果这样的话,插件Coprocessor能否处理任意格式的Row Key的下推计算呢?另外下推计算中如果使用到Index的情况下,现在的Coprocessor应该也无法处理非TiDB格式吧?

Exactly,从这个描述来看我觉得还是需要插件来解决,写插件注册为一个服务,自行按照某个逻辑扫表、执行某个计算并决定返回什么数据。现在的 Coprocessor 协处理与 TiDB 深度绑定,协处理其他任务不大够。

这样的话可以与现有的默认Coprocessor并存,对TiDB那边影响比较小。不过这样的话插件系统的设计也将会是一个复杂的工作。但是我希望能够有这个功能,这能极大的拓展TiKV的适用范围,可以作为更多的需要分布式事务存储系统的后端。

在 4.0 还是有看到不少日志命名不统一的,举个例子,region id 在 pd.log 里写的是:[region-id=xxxx],在 tikv 里则是 [region_id=xxxx]

在程序员的世界里,中划线 - 在特定场景下可能会有特定的意义,建议全部统一成下划线 [region_id=xxxx]

所有的命令行增加auto complete,加强易用性

br备份恢复工具。支持恢复时修改表名或者库名。