Pd tidb tikv间网络延迟咋样

这个效果不是很明显,又写不进去了

网络延迟应该不是问题,因为我们这边也用Citus这样的组件,性能还是比较正常的。

不过这个两个链接,其实可能也不会提升很大,124 TPS,提升成280 TPS嘛,感觉也不是TiDB的真实实力。

你好,想问一下分布式事务可以关掉吗,这个对写入影响还是很大的。

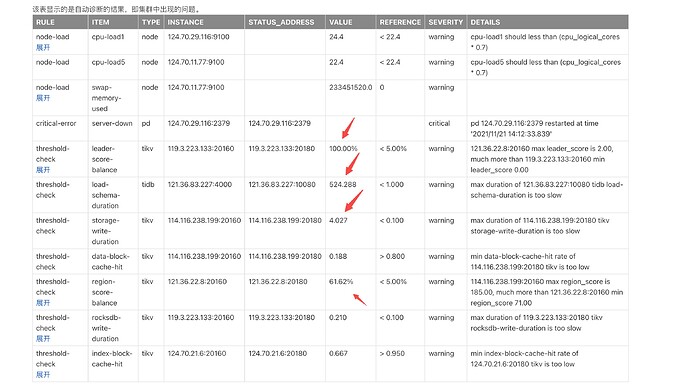

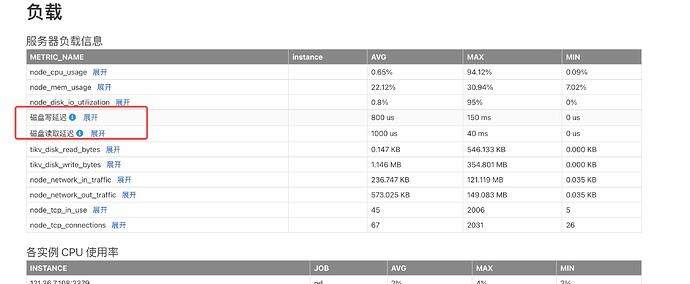

主要是磁盘慢吧,看你的诊断报告里面好几项提示是关于磁盘慢的。至于在这些条件下怎么调快,试试乐观事务+自动重试。

嗯,这个我们昨天尝试过,不过效果一般吧,只能保证select * from table limit 10能返回结果,如果用sysbench压,还是会出问题

加自动重试的话,sysbench压不会报错吧。

嗯,只能压2000万的数据量,而且TPS也会比较低。

数据量少吧,看leader_score不一样,是分布不均匀吧,用官网sysbench的数据量压,然后和官网的对比。

然后压测过程中打开grafana,看看各组件的监控信息。然后iostat看看是不是磁盘的io都满了。

https://docs.pingcap.com/zh/tidb/stable/exporting-grafana-snapshots#将-grafana-监控数据导出成快照 参照这个导出overview ,tikv detail ,tidb, pd ,disk performance, node exporter的快照看看

我按照这个参数调过了,好像也还是不太行,现在写入都比较费劲。

1、有fio吗?或者其他工具,测下硬盘IO顺序写速度

参考链接(https://blog.csdn.net/qq_36357820/article/details/79965014)

如果没做raid,你的压力可能全在磁盘上

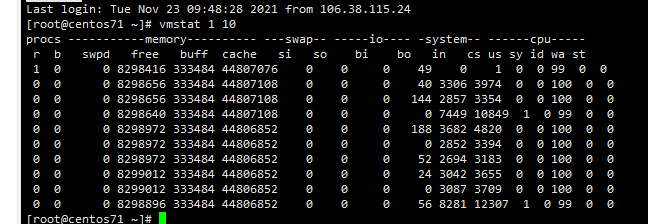

2、prepare阶段,在tikv节点上打个vmstat 1 10看看

3、把自动统计更新关了(set global tidb_auto_analyze_end_time=‘05:00 +0000’)

这个在prepare阶段,敲这个命令,是如何操作呢,主要是如何卡在prepare这个阶段呢

我推测你现在压力全在IO上,机械和SSD的性能有非常大的差距;

第一个是看下tikv所在节点磁盘的顺序写性能(因为是LSM),甚至可以评估下你的insert速度

第二个是看下sysbench准备数据时,tikv主机的压力点在哪,有多堵

第三个是减少大量insert时不必要的统计更新数据

vmstat 在你跑sysbench时再输出(记得是在tikv节点上)