为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

-

【TiDB 版本】:3.0 ga 版本

-

【问题描述】:

1.这个问题非常奇怪

问题描述

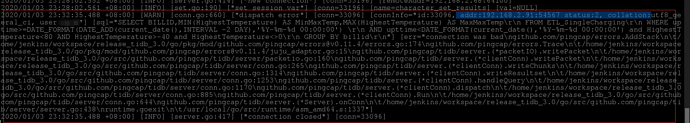

1.基于表A,一直跑着一个sql,使用kettle 执行,获取数据,昨天新建了表B,但是发现今天表A的sql,一直无法返回结果,使用kettle的tableinput,查看showprocesslit,sql一直存在,这个时候,从cpu和内存看,都执行完成了,很长时间之后,showprocesslist 的sql 消失,但是还是无结果。今天把昨天新建的表B,删除了,竟然A的sql 回复了。 想不明白。

完全没有关系的2个表,咋会影响呢 -

2.表A的sql:

SELECT billid,Max(StartTime) as StartTime,MIN(soc) AS rbsoc,MAX(soc) AS RESOC,

MAX(HighestTemperature) AS RHT,MIN(lowestTemperature) AS RLT,

MAX(HighestTemperature-lowestTemperature) AS RDiffT,

MAX(HighestVoltage) AS RSHV,MIN(LowestVoltage) AS RSLV,

MAX(HighestVoltage-LowestVoltage) AS RDifV,

IFNULL(

(

ROUND(max(CurrentElectricMeter))-ROUND(max(BillInitElectricMeter))

),0) AS RPower,

MAX(DemandVoltage) AS MaxDV, MIN(DemandVoltage) AS MinDV,MAX(DemandVoltageDemandCurrent) AS MaxDP,

MAX(DirectPower) AS MaxAP, SUM(DemandVoltageDemandCurrent) AS DPower,SUM(DirectPower) AS APower,

MAX(DirectVoltageDirectCurrent) AS MaxPower,MAX(DirectVoltage) AS MaxRv,MAX(DirectCurrent) AS MaxRc,

MAX(DemandCurrent) AS MaxDC,ROUND(AVG(DemandVoltageDemandCurrent),2) as AvgDP,ROUND(AVG(DirectPower),2) as AvgPower,

ROUND(sum(DemandVoltage),2) as SumDV,ROUND(sum(DemandCurrent),2) as SumDC,

ROUND(sum(DirectVoltage),2) as SumAV,ROUND(SUM(DirectCurrent),2) as SumAC

FROM ETL_SingleCharging

WHERE upttime>=DATE_FORMAT(DATE_ADD(current_date(),INTERVAL -2 DAY),‘%Y-%m-%d 00:00:00’)

AND upttime<DATE_FORMAT(current_date(),‘%Y-%m-%d 00:00:00’)

GROUP BY billid

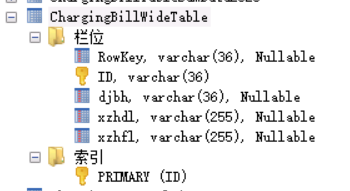

- 3.表B的数据结构

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出打印结果,请务必全选并复制粘贴上传。