为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:DM版本,刚升级为1.0.3

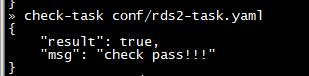

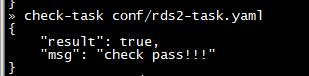

- 【问题描述】:因昨天同步上游数据库binlog日志被清理,导致同步失败,恢复不了,昨日刚升级了DM1.0.3,今天下线worker之后,重新配置worker启动成功,之后启动task任务检查通过,但是start之后出现问题,问题请看下面截图。

下面是具体错误日志

为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

现在需要重新初始化对吧?下游库已经清空?麻烦把tidb. log 上传下,看下具体错误,以及 task. yaml

tidb. log 错误发的全一点吧,dispatch 过滤,从8.17

现在有一个任务同步正常了?!

不对啊,正常先要全量导出导入的,可以把 dm 日志和 tidb.log 发出来吗?

看下下游有没有库?这个库很小?

这样写果然只同步了一个库,只同步了白名单的那个库。

但是rds1是同步成功了。

虽然只有一个库

感觉 ignore db 那个位置有问题,先注释掉这张表不同步,先做正常同步,然后停止。再加回去不同步,可以看下rds1是不是没有 ignore db

我改一下task吧,把白名单的那个去掉。然后我停掉task,下线worker,删掉下游的load表和sync表,重新同步一下吧。重新操作。看看是不是还不行。

好的,可以把日志传上来,我们看看

目前rds1是可以了,正在Dump中,目前是没有问题的。我再试一下rds2吧

好的 有问题随时提问

我同步到66个G的时候,目前状态是Dump,我去worker节点看文件夹大小已经66个G了,不知道为什么,突然重新开始了。我在查看worker节点的时候变成2.2的G了,又重新开始了?我看状态是没问题的,监控什么也没问题。 详细请看链接,我又开了一个帖子。