为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

【概述】 场景 + 问题概述

【背景】 做过哪些操作

【现象】 业务和数据库现象

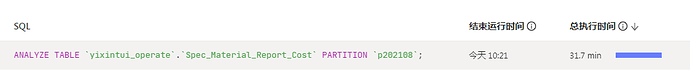

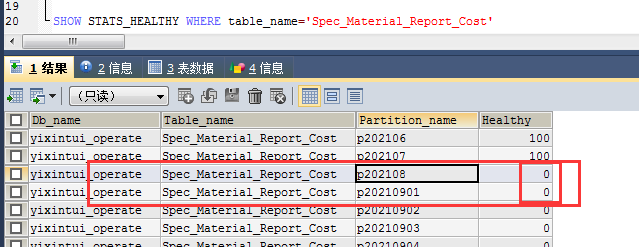

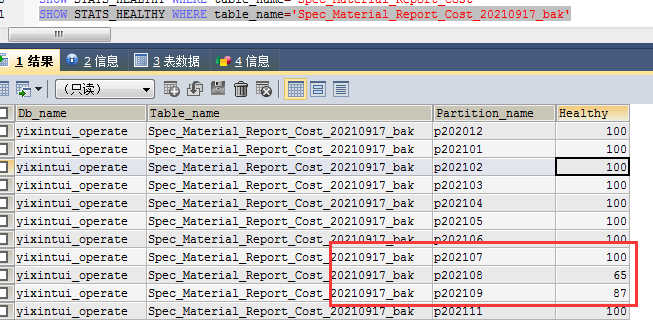

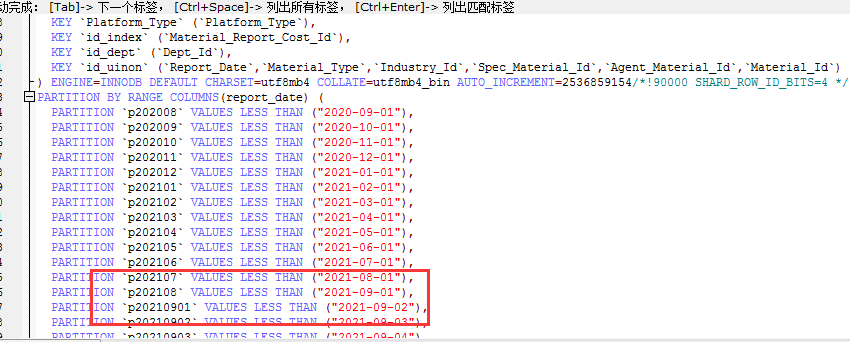

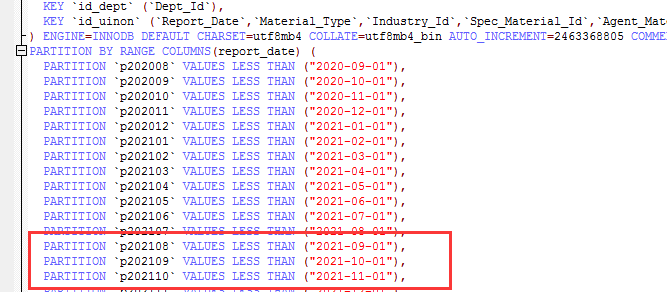

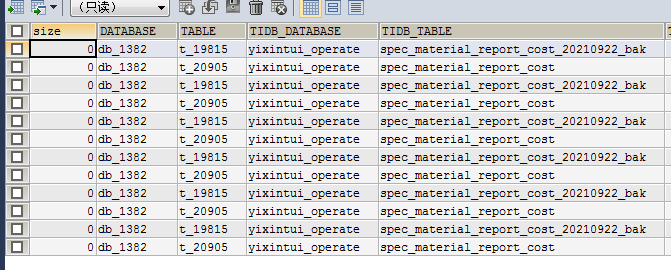

【问题】 #时间改成 Report_Date>= ‘2021-08-01’ AND Report_Date< ‘2021-08-25’ 是可以成功的 数据量少一些的话

SELECT Report_Date,Img_Path,mrc.Material_Type,mrc.Material_Name,mrc.Material_Original_Name,mrc.Spec_Material_Id,mrc.Material_Id,Agent_Material_Id,mrc.Spec_Id

,GROUP_CONCAT(DISTINCT ‘(’,mrc.Spec_Id,’)’,Spec_Name ORDER BY mrc.Spec_Id SEPARATOR ‘、’) AS Spec_Name

FROM

Spec_Material_Report_Cost mrc

WHERE Report_Date>= ‘2021-08-01’ AND Report_Date< ‘2021-08-28’

GROUP BY mrc.Spec_Material_Id

错误代码: 1105

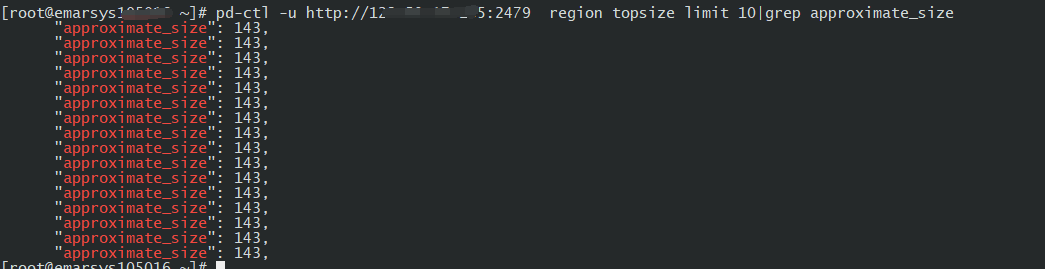

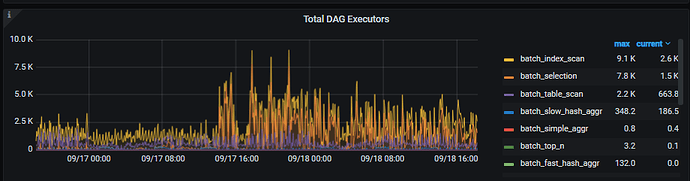

[FLASH:Coprocessor:Internal] DAG response is too big, please check config about region size or region merge scheduler

执行计划

| id | estRows | task | access object | operator info |

|---|---|---|---|---|

| Projection_6 | 259564.36 | root | yixintui_operate.spec_material_report_cost.report_date, yixintui_operate.spec_material_report_cost.img_path, yixintui_operate.spec_material_report_cost.material_type, yixintui_operate.spec_material_report_cost.material_name, yixintui_operate.spec_material_report_cost.material_original_name, yixintui_operate.spec_material_report_cost.spec_material_id, yixintui_operate.spec_material_report_cost.material_id, yixintui_operate.spec_material_report_cost.agent_material_id, yixintui_operate.spec_material_report_cost.spec_id, Column#44 | |

| └─HashAgg_7 | 259564.36 | root | group by:Column#60, funcs:group_concat(distinct “(”, Column#48, “)”, Column#49 order by Column#50 separator “、”)->Column#44, funcs:firstrow(Column#51)->yixintui_operate.spec_material_report_cost.report_date, funcs:firstrow(Column#52)->yixintui_operate.spec_material_report_cost.img_path, funcs:firstrow(Column#53)->yixintui_operate.spec_material_report_cost.material_type, funcs:firstrow(Column#54)->yixintui_operate.spec_material_report_cost.material_name, funcs:firstrow(Column#55)->yixintui_operate.spec_material_report_cost.material_original_name, funcs:firstrow(Column#56)->yixintui_operate.spec_material_report_cost.spec_material_id, funcs:firstrow(Column#57)->yixintui_operate.spec_material_report_cost.material_id, funcs:firstrow(Column#58)->yixintui_operate.spec_material_report_cost.agent_material_id, funcs:firstrow(Column#59)->yixintui_operate.spec_material_report_cost.spec_id | |

| └─Projection_20 | 324455.45 | root | cast(yixintui_operate.spec_material_report_cost.spec_id, var_string(20))->Column#48, yixintui_operate.spec_material_report_cost.spec_name, yixintui_operate.spec_material_report_cost.spec_id, yixintui_operate.spec_material_report_cost.report_date, yixintui_operate.spec_material_report_cost.img_path, yixintui_operate.spec_material_report_cost.material_type, yixintui_operate.spec_material_report_cost.material_name, yixintui_operate.spec_material_report_cost.material_original_name, yixintui_operate.spec_material_report_cost.spec_material_id, yixintui_operate.spec_material_report_cost.material_id, yixintui_operate.spec_material_report_cost.agent_material_id, yixintui_operate.spec_material_report_cost.spec_id, yixintui_operate.spec_material_report_cost.spec_material_id | |

| └─TableReader_13 | 324455.45 | root | data:Selection_12 | |

| └─Selection_12 | 324455.45 | cop[tiflash] | ge(yixintui_operate.spec_material_report_cost.report_date, “2021-08-01”), lt(yixintui_operate.spec_material_report_cost.report_date, “2021-08-28”) | |

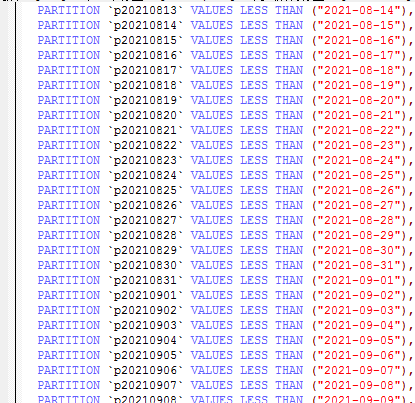

| └─TableFullScan_11 | 12978218.00 | cop[tiflash] | table:mrc, partition:p202108 | keep order:false, stats:pseudo |

【业务影响】

【TiDB 版本】

5.1.1

【应用软件及版本】

5.1.2 已经修复

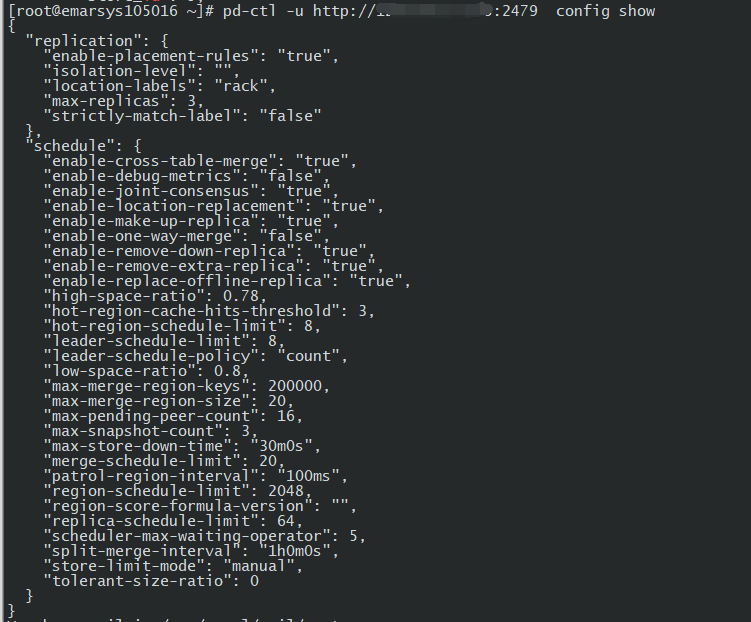

【附件】 相关日志及配置信息

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/)

- TiDB-Overview Grafana监控

- TiDB Grafana 监控

- TiKV Grafana 监控

- PD Grafana 监控

- 对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。