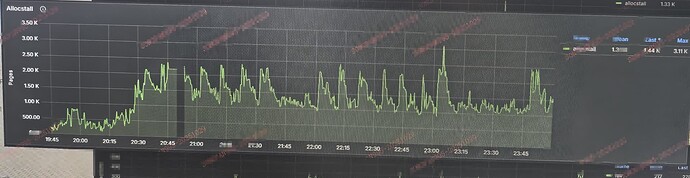

swap观察下

![]() node export 用的不是 tidb 自带的么?

node export 用的不是 tidb 自带的么?

5.0.0的版本,metrics里好像就是没有这个

swap没有使用

之前多久没重启了

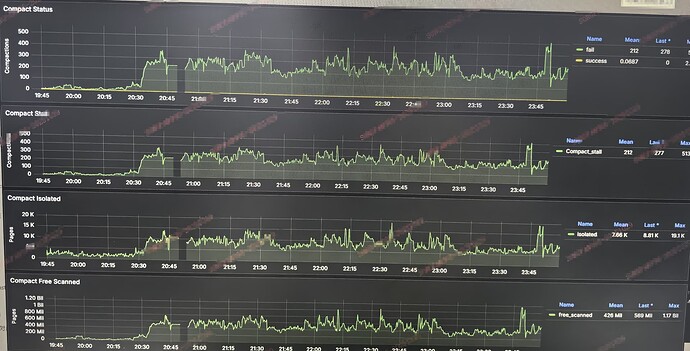

这两天分析了一下tikv的内存分布。发现tikv分配内存会倾向于在numa 的 node1进行分配。95%会在node1 的normal分配,5%会在node0的normal分配。

这个似乎也解释了buddyinfo为啥会看到node1的碎片比node0更加严重。

uptime才3个月

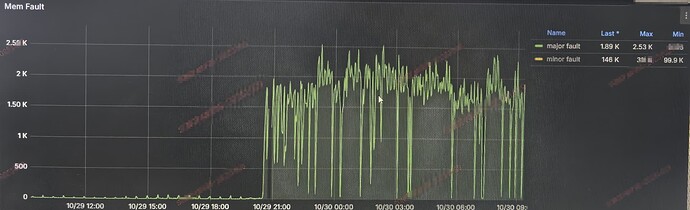

今天发现不是nodeexporter太老了,而是nodeexporter没有开 ![]()

但是重启了一台tikv,已经恢复了,估计短时间不会再出

1 个赞

swap未使用呢

有热点数据了吧

配置缓存读写

增大内存,提高缓存

页失败,扩容内存

提高读命中率

有些metric信息没有采到啊

好家伙,nodeexporter没打开,cpu\mem漏了不少数据吧

已经把vmstat,numa的和buddyinfo都打开了,重启tikv后,问题没有再出现了,可能要等一段时间了

但现在内存才使用50%

大佬,每太明白,热点数据具体指什么,缓存读写是配置哪个