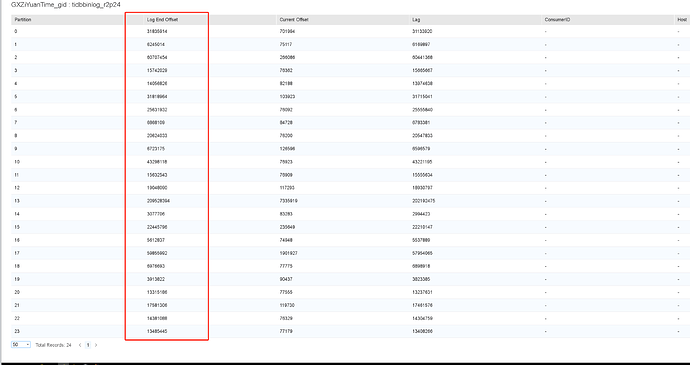

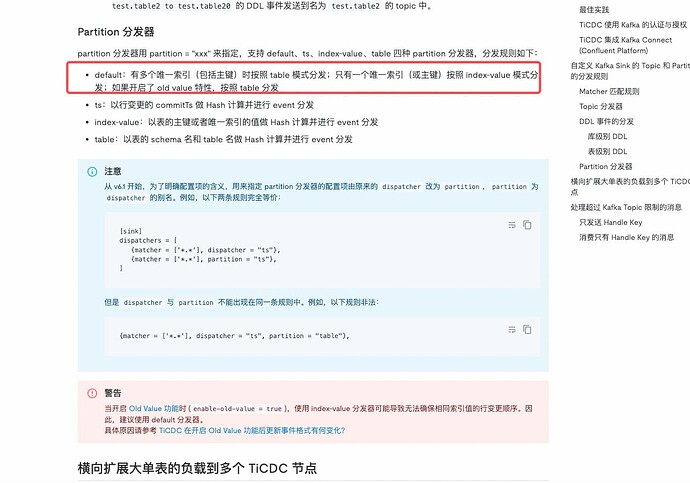

TiCDC 同步数据到下游kafka,下游有24个 partition,发现这24的partition 消息分布不均匀,有没有好的方式使其均匀分布?

你现在配置什么样的。

默认的,changed的配置里面只配置了 rules 以及 force-replicate=true

然后我改了,然后50多分钟ts一直没推进 ![]() ,库里面近10w张表

,库里面近10w张表

任务重建 需要扫一遍 region。

你看下 cdc 监控里面的 unresovle region 数量在不在下降。

扫完就开始了。

1 个赞

这个值一直是0

踩坑了? 坐等后续的进展

看下tick → tikv → initial scan task status 有没有下降了

1 个赞

日志有报错吗?

任务重启或者重建就会重新扫,一直是 0 有问题啊。