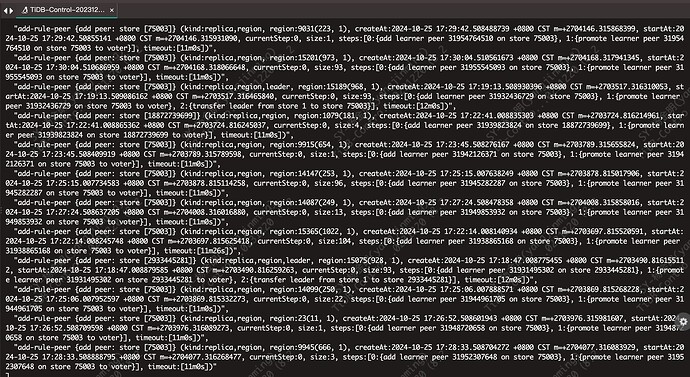

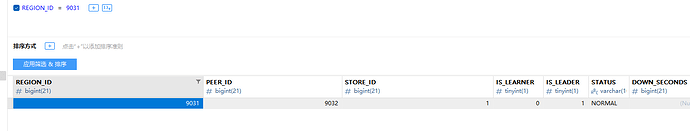

看这个日志, 他在往另一台上去添加副本,你按这个region id 搜下tikv.log 和pd leader的log 看看有没有啥报错信息, 还有就是你说的缩容报错,看你发的日志 这一个正常的Info信息,你说的报错是什么样。你注意观察下store_id=1上的region count是不是再减少 其他上的再增加,我感觉这个上的region 得要先补完副本 才能处理下线的操作。 region_count 可以从 tikv_store_status里直接查 或者 直接看监控 overview-> tikv 里的region/leader监控

我的目的就是要先在新机器扩容tikv,然后缩容掉 100上面的TIKV ,然后缩容的100上面的TIKV一直报上面的错误, 报错了 2天,副本并没减少,并没有往其他机器补副本成功。然后我查了下 100上面的tikv 的region都是单副本,我猜是region单副本导致一直缩容不了,一直报错

如果其他节点一直副本没补成功,看看日志里能不能看到些信息。

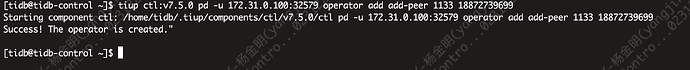

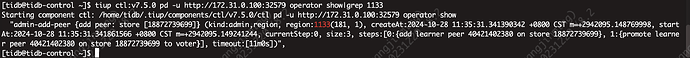

operator add add-peer 2 5:在 Store 5 上为 Region 2 添加 Peer

用pd-ctl 试试手工再其他节点添加副本能不能成功

好的 我查下日志,由于我怕影响业务,停止下线了,已经停一天了。有个问题请教下 ,为啥100上面都是单副本?是因为在最开始部署的时候,只部署了一个tikv节点,那就不会存在follower,只会有个单副本,即使PD参数观察是副本数=3,也不会去复制副本吗?那这是不是很鸡肋啊

单副本肯定是因为你就一个tikv , 也很好奇为啥你没调整max-replicas 单副本也能跑起来。 理论上你副本数是设置3 ,是会补副本的。

默认max-replicas就是3吧 。

tiup cluster display 看下集群状态

我知道是3,我建议改成其他的在改回3,重新触发下副本数调整

目前5个副本我可以改成4,这种改会不会影响调度呢?

改完就会立刻进行调度,你再改回去

还是得看日志啊,找个region 看看pd leader 和 tikv.log 有啥报错导致调度下发了,但是执行不成功