下个月中旬开始做

哦那我这个图 当前生产这个节点没有leader吧?只有副本region对吧。

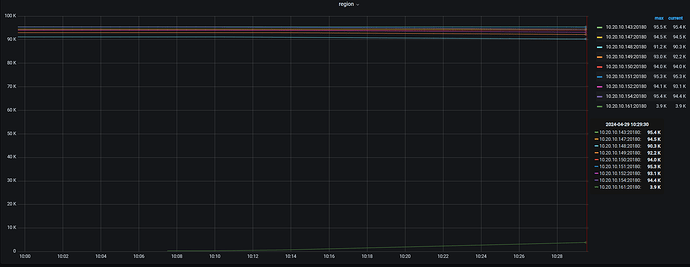

如果缩容,节点对应的leader和region都会一直降低 看这个时间对吧?缩容的时候我去观察看看。如果有点慢再去调整store limit

是的,是这个意思

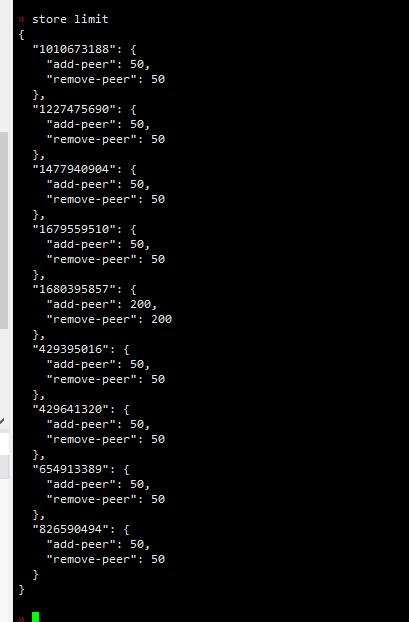

你这个是默认是50 其中一个itkv的id单独调整为200吗?

对的,新增的节点适当调大了点

不急就等他慢慢迁移,如果你很急就等业务低谷大半夜的时候一下子全部调大,迁移完调回来。

一定等region变成tombstone才可以删除。否则就丢副本,然后期间再故障一台机器就不能正确提供服务了。

不会吧,我30台tikv呢。。我理解的是随便挂掉两三台 不会有问题。 ![]()

你是阿里云SSD服务器吗??你这是对应的那个节点调整为200, 半小时 4kregion?吗?如果没调整岂不是更慢?

你有按机架分组码?如果没有,按host调度的话,任意挂两台都会导致一些region的双副本丢失,就没法提服务了。

是整个tidb不能提供服务还是 挂掉的2台对应的region不能查询??

你保证同一时间只有一个TiKV在下线就行

如果挂掉的2台对应的region只是普通的表,那就是这些region不能访问,如果这个region是meta信息,那tidb-server超过租期后获取不到meta信息,就整个集群不能访问了。

30多台机器还是建议分个组,按错误域调度。阿里应该有这种参数。

好吧,我还以为我有30个,我可以随便挂呢 ![]() 你说的分组是 阿里云上面控制台的分组还是pd里面对tikv分组?

你说的分组是 阿里云上面控制台的分组还是pd里面对tikv分组?

store limit 200 意思是每分钟迁移上限是200,你按照这个算下速度呗

对tikv分组。告诉tikv(0-9)是一组,tikv(10-19)是一组,tikv(20-29)是一组,这样的话,组内只有1副本,组内随便挂几台都没问题,只要有2个组完整的运行,就不影响。

组可以从阿里看看有没有错误域之类的信息,把多台机器按错误域分组。比如说:同一个交换机,同一套电源,这就是一个错误域。

哦哦。这就是两个方案吧,1个就是 tikv的几个ip 分组,这样之后可以不管,也可以再继续去阿里上面吧对应分组机器划分一下不同域。了解了。谢谢

能找到阿里的机架信息就按机架信息分组,这样更安全。找不到就自己逻辑上分组就行了。不分组混着来只能挂2个。

也就是说其实不分组的话只能看运气了。如果挂两个,就看这两个里面有没有某个region的2个副本 如果没有 没影响,如过有,对应region 无法访问是吧?