不备份

单独备份表,每个表创建一个任务,存储在对象存储中,最好是ceph这种类似的分布式存储。

全备比较难吧 重点表备份

我们都是周日全量备份,周一到周六增量备份。

这么大,多久能备完

1、这么大数据量,如果全是在线业务数据,直接改成多节点吧,单节点省下的成本可能不够日常备份的费用,还丢失了tidb本身自带的灾备特性,加上备份恢复花费的时间精力,有点得不偿失;

2、如果不是在线业务数据,就分类挑表进行备份;

1 个赞

我们都是增量备份

讲实话,这么大的数据量不是考虑备份的问题了,而是考虑怎么拆分或者归档历史数据

1 个赞

果然,数据时代,数据量都已经到P级了

![]() 数据量 几百T。想数据安全,成本又是问题。可以单纯的寄希望于tidb的安全性。 有资金就上灾备。

数据量 几百T。想数据安全,成本又是问题。可以单纯的寄希望于tidb的安全性。 有资金就上灾备。

工作这么多年我还没见过几百T在一台机器上 ![]()

![]() 既然用了TiDB,就可以排除几百T都在一台机器上的可能。毕竟分布式系统不是白叫的。

既然用了TiDB,就可以排除几百T都在一台机器上的可能。毕竟分布式系统不是白叫的。

2 个赞

选择性备份吧!

只备份某些单表

只能全备+增备了

用从库的方式,同步所有数据做备份。然后,关键的数据再单独备份一下,保留几个历史版本。

重要的业务 200t 考虑下业务侧拆分下呢

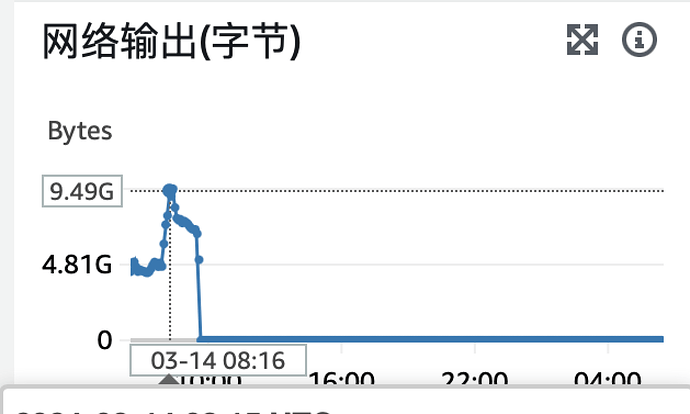

这么大的体量,以我的认知的话,传统的全备+增量备份应该不太现实,对存储、网络带宽的压力太大了。

可以考虑搭建两套集群,利用数据同步工具进行备份。

主集群可以使用性能较好的配置,备集群可以使用单节点+性能较低的存储的方式进行备份。

1 个赞

考虑数据拆分,一套集群200-1000T的数据量,确实有点吓人。tidb是单节点,tikv不会也是单节点吧!

1 个赞