【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

-

集群信息

tidb 版本 v5.1.4

tispark 版本 v3.2.2 ,是从 2.5 升级过来的 -

遇到问题

集群 update 性能较差,经过分析排查,是 gc 没正常工作,下面是 gc 信息

tikv_gc_last_run_time | 20231211-15:35:17 +0800

tikv_gc_safe_point | 20231109-15:34:12 +0800

下面是 pd-ctl 查看到的信息

» service-gc-safepoint

{

“service_gc_safe_points”: [

{

“service_id”: “gc_worker”,

“expired_at”: 9223372036854775807,

“safe_point”: 446241575371538432

},

{

“service_id”: “ticdc”,

“expired_at”: 1702363646,

“safe_point”: 446236079548530688

},

{

“service_id”: “tispark_161d033e-79ed-4d86-920e-2421541cbcee”,

“expired_at”: 1702277526,

“safe_point”: 445841422866710913

},

{

“service_id”: “tispark_31b3b228-3e1c-4719-b103-8313a8d54ed6”,

“expired_at”: 1702277538,

“safe_point”: 445786124389712129

},

{

“service_id”: “tispark_36ce4519-3041-4d11-a23f-db53a6f484eb”,

“expired_at”: 1702277568,

“safe_point”: 445991471693693035

},

{

“service_id”: “tispark_4c225448-330f-448f-bd32-9a858963888c”,

“expired_at”: 1702277584,

“safe_point”: 445518167438000131

},

{

“service_id”: “tispark_af3b67b4-8e0c-42b2-8d0f-86bd77091e6a”,

“expired_at”: 1702277569,

“safe_point”: 445991471995158529

},

{

“service_id”: “tispark_c42ced32-87be-4ac5-b035-9c75fd8e1e3e”,

“expired_at”: 1702277571,

“safe_point”: 445991472873340930

},

{

“service_id”: “tispark_cbe81364-7e10-402c-b41d-709469892090”,

“expired_at”: 1702277571,

“safe_point”: 445518384558768521

},

{

“service_id”: “tispark_f58f0569-6e9b-41b6-93f8-c311ee179142”,

“expired_at”: 1702277564,

“safe_point”: 445536642717974864

},

{

“service_id”: “tispark_fdd4b490-6675-4168-b812-7c25b79d6858”,

“expired_at”: 1702277580,

“safe_point”: 445517726367612929

}

],

“gc_safe_point”: 445517726367612929

}

下面是对上面信息做的时间戳转换

tso 446241575371538432 # 2023-12-11 14:35:17.378 +0800 +08

tso 446236079548530688 # 2023-12-11 08:45:52.477 +0800 +08

tso 445991471693693035 # 2023-11-30 13:34:07.562 +0800 +08

tso 445991471995158529 # 2023-11-30 13:34:08.712 +0800 +08

tso 445991472873340930 # 2023-11-30 13:34:12.062 +0800 +08

tso 445841422866710913 # 2023-11-23 22:34:16.712 +0800 +08

tso 445786124389712129 # 2023-11-21 11:58:29.763 +0800 +08

tso 445536642717974864 # 2023-11-10 11:36:52.712 +0800 +08

tso 445517726367612929 # 2023-11-09 15:34:12.562 +0800 +08

tso 445518167438000131 # 2023-11-09 16:02:15.112 +0800 +08

tso 445518384558768521 # 2023-11-09 16:16:03.362 +0800 +08

下面是部分 tidb 日志

[2023/12/11 15:56:18.370 +08:00] [INFO] [gc_worker.go:292] [“[gc worker] there’s already a gc job running, skipped”] [“leaderTick on”=630cd6166400013]

[2023/12/11 15:57:17.373 +08:00] [INFO] [gc_worker.go:292] [“[gc worker] there’s already a gc job running, skipped”] [“leaderTick on”=630cd6166400013]

[2023/12/11 15:58:17.424 +08:00] [INFO] [gc_worker.go:292] [“[gc worker] there’s already a gc job running, skipped”] [“leaderTick on”=630cd6166400013]

[2023/12/11 15:59:17.662 +08:00] [INFO] [gc_worker.go:292] [“[gc worker] there’s already a gc job running, skipped”] [“leaderTick on”=630cd6166400013]

[2023/12/11 16:00:17.450 +08:00] [INFO] [gc_worker.go:292] [“[gc worker] there’s already a gc job running, skipped”] [“leaderTick on”=630cd6166400013]

[2023/12/11 16:00:18.957 +08:00] [INFO] [gc_worker.go:1046] [“[gc worker] finish resolve locks”] [uuid=630cd6166400013] [safePoint=445517726367612929] [regions=1450275]

以下是几个问题,请帮忙看下,谢谢

- 如何根据 pd-ctl 输出的 service_id 查看对应的 changefeed-id ?知道信息后方便删除任务

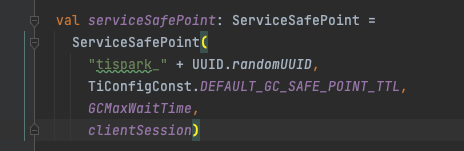

- tispark 任务如何删除?貌似没办法删除,这个问题 asktug 上也有类似问题,一直没得到解决,希望帮忙看下,也可以帮助遇到类似问题的其他人

- 为什么 gc 默认保留 24 小时,但是一个月前的还没正常 gc ,下面是官方文档说明

https://docs.pingcap.com/zh/tidb/stable/ticdc-faq#ticdc-的-gc-ttl-是什么

以上第二种行为是在 TiCDC v4.0.13 版本及之后版本中新增的。目的是为了防止 TiCDC 中某个同步任务停滞时间过长,导致上游 TiKV 集群的 GC safepoint 长时间不推进,保留的旧数据版本过多,进而影响上游集群性能。

专栏 - TiSpark v3.0.3 & v3.1.3 发布 | TiDB 社区