rpc num 就是访问的region 数量吗?

cop task

是不是数据比较分散,需要访问303个region 才能查到数据

6.5.3 上面根据这个文档,为了解决读热点,将这个参数改为了如下设置,原集群5.4.3没动这个参数

https://docs.pingcap.com/zh/tidb/v6.5/configure-load-base-split#使用方法

设置 QPS 阈值为 1500

SET config tikv split.qps-threshold=1500;

设置 Byte 阈值为 15 MiB (15 * 1024 * 1024)

SET config tikv split.byte-threshold=15728640;

这个确实能导致region 分裂更多

对,为了解决读热点,数据分散一些,然后6.5.3现在还有2W个空region,原集群只有1K多个

有没有手动调用系统自身的compact

region越多rpc越多吧

多搞几个TIKV节点,同个IP不同端口,加大单个region大小

现在是做过什么操作了

合并掉哪些 空 region,可以提升点性能

把空region合并了,之前2W多个空region,现在4K多

好像是之前打开这个参数

设置 QPS 阈值为 1500

SET config tikv split.qps-threshold=1500;

设置 Byte 阈值为 15 MiB (15 * 1024 * 1024)

SET config tikv split.byte-threshold=15728640;

导致数据太分散了

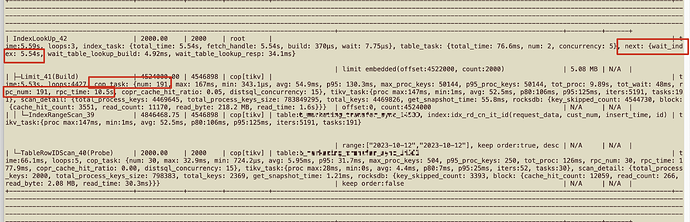

通过执行计划的这个值,可以看出

5.4.3

max_proc_keys: 802166

6.5.3

max_proc_keys: 50144

可是把这个参数改为原来的默认值,今天的数据还是有问题,还是慢,rpc_num还是多

这个也是深分页的SQL,在5.4.3没有问题

合并后性能好转了吗 rpc少了吗

rpc 次数少了,但是还是很慢

发现这个参数差距挺大的,怎么调整

5.4.3

max_proc_keys: 802166

6.5.3

max_proc_keys: 50144

发现这个参数差距挺大的,怎么调整

5.4.3

max_proc_keys: 802166

6.5.3

max_proc_keys: 50144

这个是 tikv 扫描 kv 数据的最大值,调整不了吧,执行计划自己选择的,不是啥参数