【 TiDB 使用环境】生产环境

【 TiDB 版本】6.5.3

【复现路径】tidb集群扩容

集群原有6台tikv服务器,每台48c ,256g内存 ,2块nvme盘,sysbench压测,100并发,tps能到4500

集群扩容了6个高配服务器(64c 256g 2块nvme)后,都是tikv,sysbench压测,100并发,tps反而降低到了3500

单独使用新增的6台高配服务器作为tikv,部署一个新集群,sysbench压测,100并发,tps能达到5200

请问这是什么原因呢,这三个测试结果都是测试多遍得出的结论

【遇到的问题:问题现象及影响】

【资源配置】

【附件:截图/日志/监控】

zhanggame1

(Ti D Ber G I13ecx U)

2

观察下资源,如果tikv不是瓶颈,增加tikv没效果的,可以考虑集群原有6台tikv服务器直接加tidb数量

1 个赞

现在这个问题可以解决,主要是需要确定原因,为何扩容高配服务器,反而性能降低了

机器多了,感觉网络通信成本也高了?

另外就是会不会调节参数好点?减少低配机器负载

负载均衡

此外,为了应对不同节点可能在性能等方面存在差异的问题,还可为 Store 设置负载均衡的权重。leader-weight 和 region-weight 分别用于控制 Leader 权重以及 Region 权重(默认值都为 “1”)。假如把某个 Store 的 leader-weight 设为 “2”,调度稳定后,则该节点的 Leader 数量约为普通节点的 2 倍;假如把某个 Store 的 region-weight 设为 “0.5”,那么调度稳定后该节点的 Region 数量约为其他节点的一半。

2 个赞

Kongdom

(Kongdom)

7

扩容之后,有没有等数据均衡了再测试?数据均衡也要消耗性能的。

2 个赞

普罗米修斯

8

观察下grafana-overview其他分布式节点(tidb、pd)的负载情况

1 个赞

随缘天空

(Ti D Ber Ivw R7o Pj)

9

首先服务器的配置不一致也有可能会影响性能,扩容时建议同一个组件的配置尽量保持一致进行测试看下效果。另外,压测时,压测时间要保持一致,否则也会影响指标数据。同时,观察下dashboard或者grafana中的tikv监控信息,看下新增加的节点是否真正发挥作用

1 个赞

修改weight试了,基本没有效果,应该是和通信成本高有关

一开始也是怀疑是网络问题,后来排查,基本排除网络问题了,都是光口交换机,其他集群测试没问题的

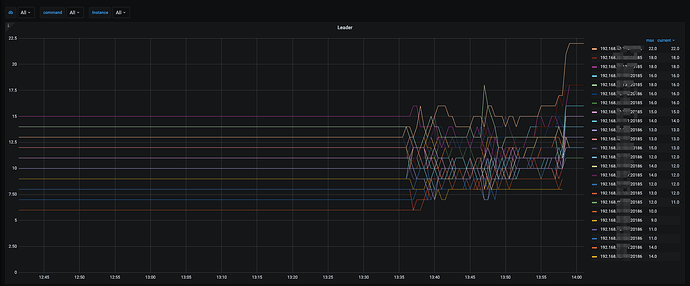

cpu负载不是很均衡,旧服务器负载高一点,新服务器负载低一点,但是整体负载不是很高,最高的不超过60%

我们的测试数据不是很多,8个100万条的表,几十个region,sysbench跑1次后基本上就均衡了

有猫万事足

16

新tikv到 pd leader 的ping值是多少?

经过今天测试,发现集群有20T的数据和空集群测试qps相差挺多,空集群tps能到4800,有20T数据tps才3500,除了数据不一致,其他都一样