wfxxh

(倔强的蜗牛)

22

兄弟,我重复了很多次了,我的ticdc任务,一直到昨天出错,任务都是正常推进的。

wfxxh

(倔强的蜗牛)

23

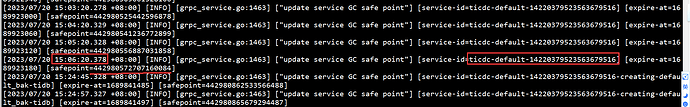

ticdc全部日志:

链接: 百度网盘 请输入提取码 提取码: w9cg

dba-kit

(张天师)

26

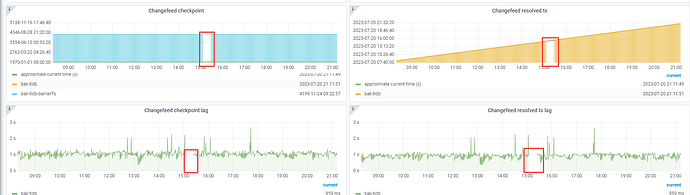

从表现上来看,像是在BR备份期间,TiCDC一直没有推进checkpoint,在超过gc_life_time(1h)后,TiCDC因为changelog被GC掉的原因,导致失败了。

wfxxh

(倔强的蜗牛)

28

我从14:28开始导出,一直到15:06 ticdc才断的,期间resolved ts 一直在增长变化

dba-kit

(张天师)

30

裤衩儿飞上天

31

是的。备份肯定没超过24小时,所以感觉可能跟br关系不大。除非他改了默认的gc-ttl

还有个奇怪的点是他报的那个checkpoint是chageefeed最一开始的checkpoint

wfxxh

(倔强的蜗牛)

33

pd日志中一直到报错之前,safepoint都在推进

dba-kit

(张天师)

37

"error\":{\"time\":\"2023-07-10T17:42:50.616674411+08:00\",\"addr\":\"10.1.3.123:8300\",\"code\":\"CDC:ErrReachMaxTry\",\"message\":\"[CDC:ErrReachMaxTry]reach maximum try: 10, error: rpc error: code = Unknown desc = [PD:tso:ErrGenerateTimestamp]generate timestamp failed, requested pd is not leader of cluster: rpc error: code = Unknown desc = [PD:tso:ErrGenerateTimestamp]generate timestamp failed, requested pd is not leader of cluster\"}

看原始报错信息是PD:tso:ErrGenerateTimestamp]generate timestamp failed, requested pd is not leader of cluster,你中间有重新创建changefeed的动作么?

wfxxh

(倔强的蜗牛)

38

中间没有,只在报错后,删除并重建了changefeed

dba-kit

(张天师)

39

有没有可能你重新创建changefeed时候,复制了老的命令,而没有修改--start-ts参数的值?感觉可以history看下当时你的执行命令