【 TiDB 使用环境】centos7.9

【 TiDB 版本】6.5

【复现路径】benchmark测试时设置100个warehouse,100TP,不加AP且不对最大吞吐做限制

【遇到的问题:问题现象及影响】同样的设置下,pg流复制集群能跑到40万的tpmC,ob在调优后能跑到24万,但是TiDB只能跑到4万,我们应用haproxy后也只有6万,所以怀疑是不是我们哪里出了问题或者是否还有什么别的调优手段

【资源配置】三台机器,每台机器上都有一个tikv和一个tiflash且二者都绑了一个numa核

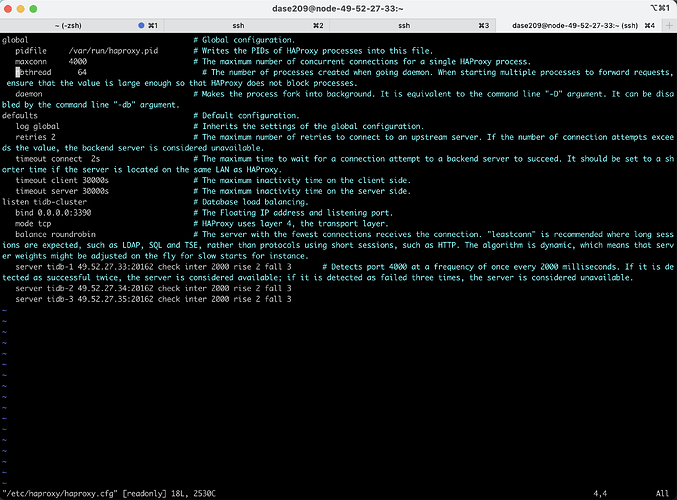

【附件:截图/日志/监控】附上haproxy配置的截图

h5n1

(H5n1)

2

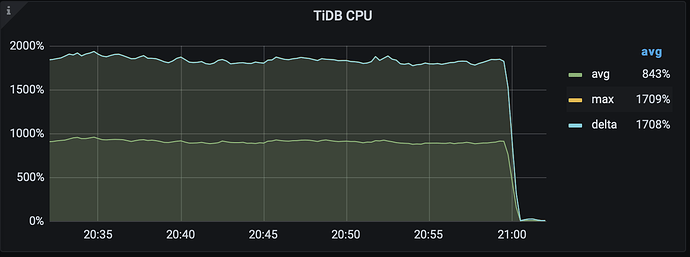

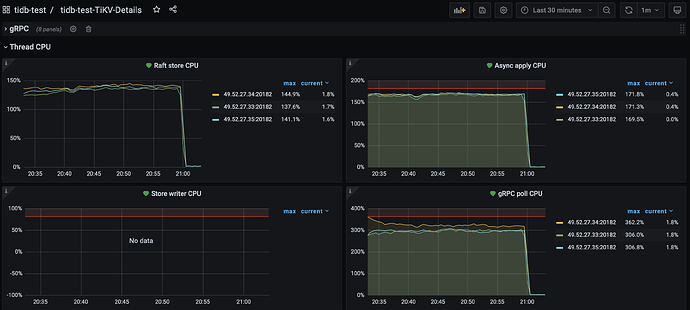

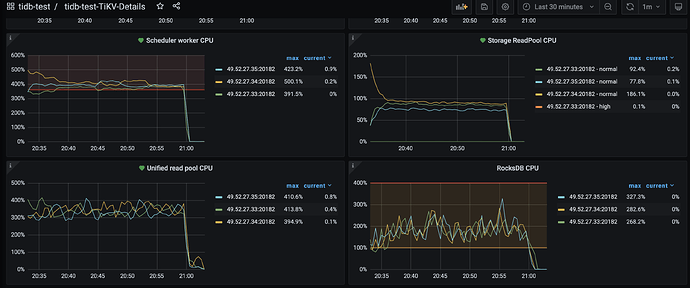

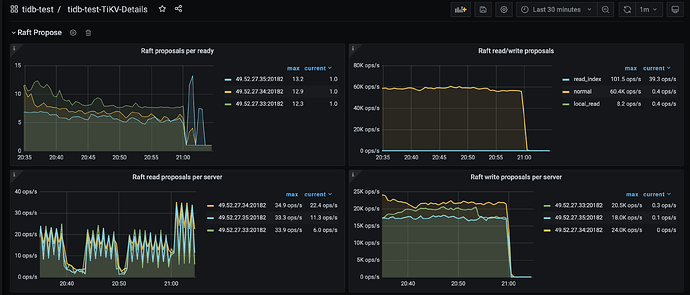

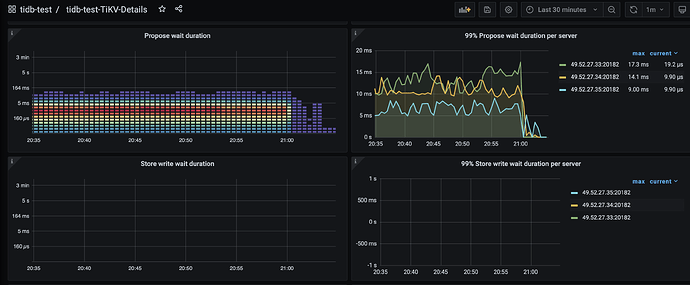

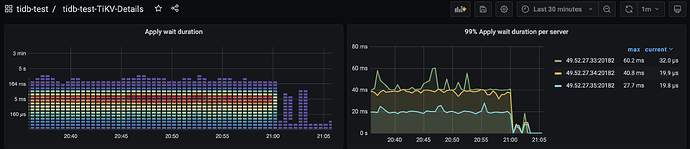

测tpmc tidb确实没啥优势。看下监控了 tidb CPU利用率、tikv-detail里thread-cpu 、raft propose 监控 、overview的磁盘性能监控。 另外再看下慢SQL 是有可调优的

2 个赞

我们用的是benchmarksql测试的,没有较重的慢查询,想问一下是否有yaml上的调优意见或者运行建议,谢谢!

1 个赞

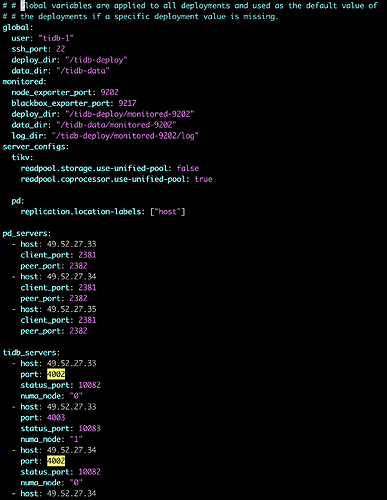

为了保证和同类产品测试的公平性,我们的搭建模式是三台机器上都有一个tikv和一个tiflash,各自占据一半的系统资源,绑定独立的numa核,且各自都具有一个tidb计算节点。目前测试来看tidb的吞吐确实拉不上去,不知道是否是部署模式或者是配置上有什么问题,谢谢!以及如果用原生的benchmarksql的话,tidb有什么针对tpcc的优化我们也可以尝试应用一下

h5n1

(H5n1)

5

官方没有专门针对tpcc的一些推荐设置或优化。 能否看下前面提的几个相关的监控。

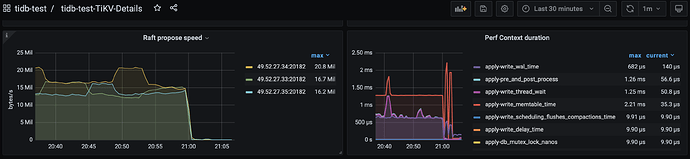

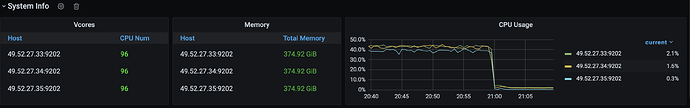

你好,我们收集了集群的一些监控信息,不知道能否得到什么优化建议,感谢!(21.00之后就跑完了,在那之后的数据没有参考价值)

magic

7

不太应该,试过tiup自带的tpcc测试了吗?我们集群80c128g机械硬盘都不止6w

1 个赞

magic

8

感觉还是要在tikv的cpu上调优,监控上有几个都达到警戒线了

1 个赞

h5n1

(H5n1)

9

1 个赞

caiyfc

10

请问网络是千兆带宽吗,看起来网络速度卡在100m/s了

1 个赞

system

(system)

关闭

12

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。