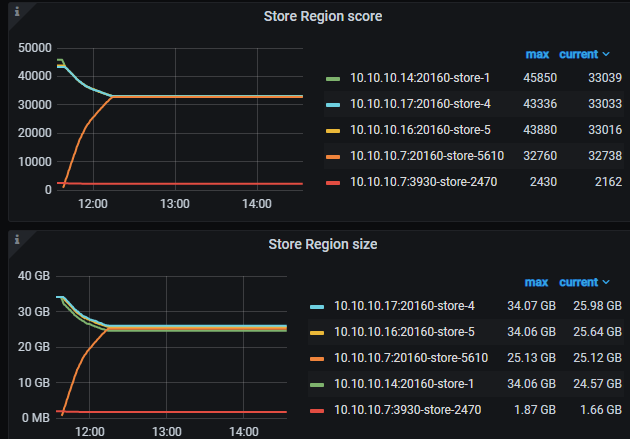

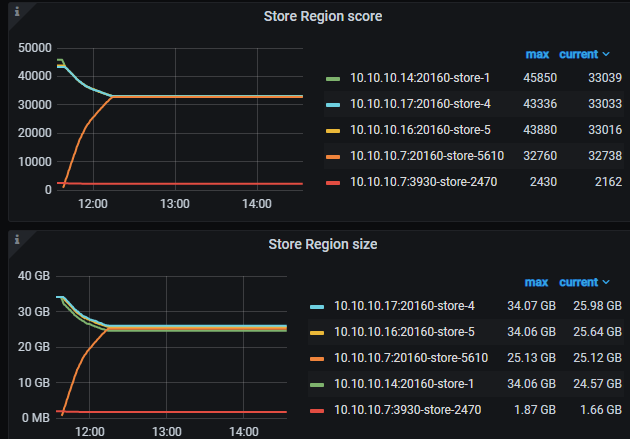

我感觉应该是你把新增的tikv都部署在了原来tikv 的节点上,并且目录都没有调整,导致tidb判断新加的节点和原来公用同一个的 CPU、内存、磁盘、网络IO,你正常在其他服务器上新增一个节点,理论上的schedule和region的走势应该是这样的,有条件的话建议试一下。

我感觉应该是你把新增的tikv都部署在了原来tikv 的节点上,并且目录都没有调整,导致tidb判断新加的节点和原来公用同一个的 CPU、内存、磁盘、网络IO,你正常在其他服务器上新增一个节点,理论上的schedule和region的走势应该是这样的,有条件的话建议试一下。

pd-ctl config show、pd-ctl scheduler show 和 information_schema.tikv_store_status 的内容看下

你看第三张图,data和deploy的目录是变了的。但不知道1节点多tikv这样的方式行不行。加节点我知道是可以的。

你没明白我的意思,/data这个目录应该挂载的都是同一块硬盘吧,他们的总IO是固定的啊。。。你又没有进行资源划分。。。如果要在一个节点上挂载多个tikv节点,首先通过numa来绑定两个节点使用不同的cpu和内存,然后挂载不同的磁盘例如/data和/data1分别给不同的节点,这样才会产生类似两个机器分别部署的效果。

嗯。理解你说的了。但按理来说,截图中方式也应该要支持吧,就像gp的segment一样。难道不允许这样做么?如果tidb判断新加的节点是共用资源,就默认是无效的么?

tikv之间的balance会考虑很多因素,例如:

我的业务场景是单机多tikv实例(打上了标签),pd 会自动 balance 数据,版本是 5.4.0

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。