我在使用TiBigData的Flink-TiDB-Connector过程中遇到一个问题:

1、【环境】

flink-tidb-connector-1.14

tidb 6.5.0

flink 1.14.3

2、【SQL】:

SET ‘execution.runtime-mode’ = ‘batch’;

SET ‘pipeline.name’ = ‘test’;

SET ‘yarn.application.name’ = ‘test’;

CREATE CATALOG mytidb

WITH (

‘type’ = ‘tidb’,

‘tidb.database.url’ = ‘jdbc:tidb://10.0.44.83:3390/its_sjzt_jg?useServerPrepStmts=true&cachePrepStmts=true&prepStmtCacheSqlLimit=1024&prepStmtCacheSize=128&rewriteBatchedStatements=true&allowMultiQueries=true&useConfigs=maxPerformance’,

‘tidb.username’ = ‘xxxx’,

‘tidb.password’ = ‘xxxx’,

‘sink.max-retries’ = ‘8’,

‘tidb.sink.impl’ = ‘tikv’,

‘tikv.sink.transaction’ = ‘minibatch’,

‘tikv.sink.buffer-size’ = ‘4096’,

‘tikv.sink.deduplicate’ = ‘false’

);

3、【出现的问题】:

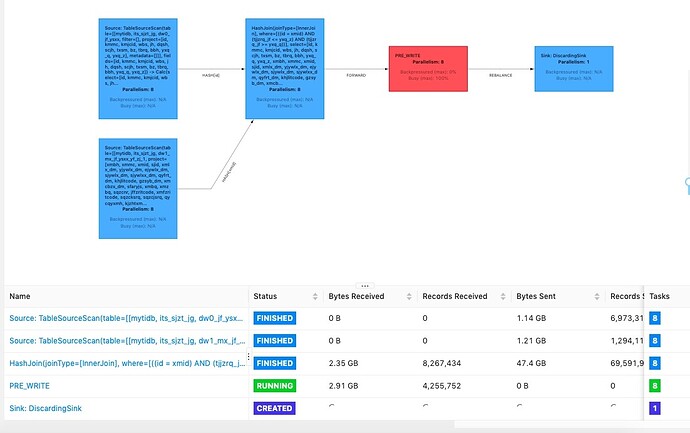

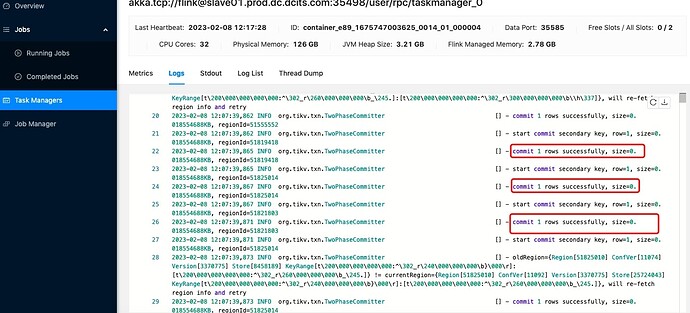

写入数据时特别慢,需要几个小时,排查发现PRE_WRITE阶段tikv.sink.buffer-size没有生效,依然是1条数据提交一次事物,详见下图: