执行scale-in 看起来是执行完了 Scaled cluster tidbonline in successfully

不过scale-in前后这个状态不变,没办法直接缩容。

目录、端口是想用回这些的,已经被占了,只能通过打patch的方式升级这部分tikv节点到 5.3.1 ,然后再启动它们?

执行scale-in 看起来是执行完了 Scaled cluster tidbonline in successfully

不过scale-in前后这个状态不变,没办法直接缩容。

目录、端口是想用回这些的,已经被占了,只能通过打patch的方式升级这部分tikv节点到 5.3.1 ,然后再启动它们?

不是的,upgrade 的所有步骤都会重新执行一遍的

不用缩容,直接修改 meta.yaml 就好,node_exporter 可以后面再排查。

tiup cluster prune 清理下 tombstone 的节点可以ok了

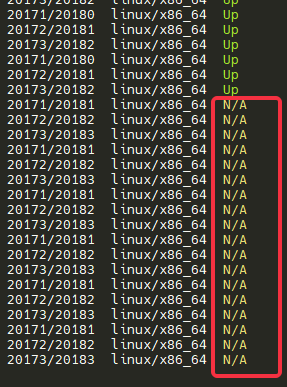

大佬,这些节点是N/A,它们没有启动起来,所以状态也不是timestone。

执行prune,它会报错:

Error: no store matching address “ip.ip.ip.ip:20171” found

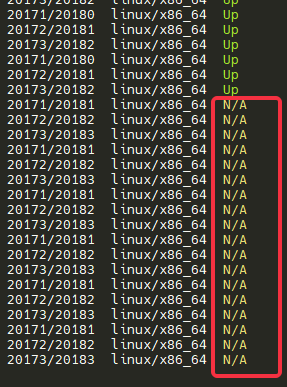

修改meta.yaml文件后直接scale-out,它也会报端口冲突:

Error: port conflict for ‘20171’ between ‘tikv_servers:ip.ip.ip.ip.port’ and ‘tikv_servers:ip.ip.ip.ip.port’

edit-cofig查看配置文件,这些计划扩容的节点配置下一个offline的信息:

offline: true

所以是先需要对这些节点执行scale-in --force,然后再用相同的路径和端口scale-out ?

scale-in --force 看看能不能缩容掉。

可以了。

对于N/A状态的节点需要先 scale-in --force 将节点从集群清理掉,修改tiup的meta信息后,再 scale-out 节点就起来了

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。