扩容TiKV节点后启动,失败,报原挂载节点已经存在问题

1、由于TIKV节点服务器重做系统问题,导致服务器挂掉

2、根据缩容过程将节点进行缩容

3、进行滚动升级

4、重新部署节点成功

5、启动节点失败

扩容TiKV节点后启动,失败,报原挂载节点已经存在问题

1、由于TIKV节点服务器重做系统问题,导致服务器挂掉

2、根据缩容过程将节点进行缩容

3、进行滚动升级

4、重新部署节点成功

5、启动节点失败

缩容时,TiKV 由几个节点缩容到几个节点,看日志该节点信息没有被踢出。因此扩容时出现 已存在的问题。

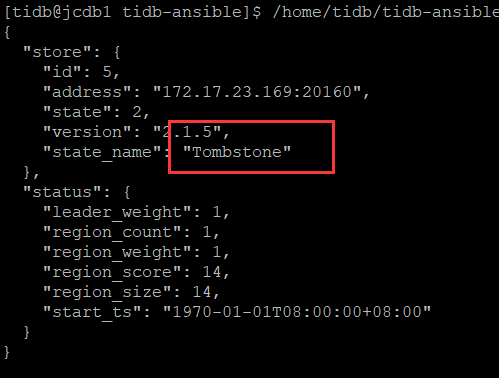

另外你是如何确保缩容成功的,状态有变成 tombstone 吗 ?

使用下线操作后提示success,但是通过查询,发现节点状态是Offline,导致后续出现ID重复问题,但是如何解决下线失败问题呢?,本KV节点系统已经重做,原系统内容已经被删除,需要如何才能正常删除?

因为 tikv 不能从 3 节点缩容到 2 节点,因此下线节点的状态不会从 offline 变成 tombstone,如果没有删除原节点数据文件等内容,可以通过以下命令将下线节点状态变为 up。

curl -X POST http://${pd_ip}:2379/pd/api/v1/store/${store_id}/state?state=Up

如果已经删除了原节点数据文件,是会造成部分数据丢失的情况。

通过先扩展节点再缩容的方式解决

一、扩容节点,完成扩容步骤后

通过新增加的节点log显示,正在提供服务

且通过节点通过指令查询成功挂载

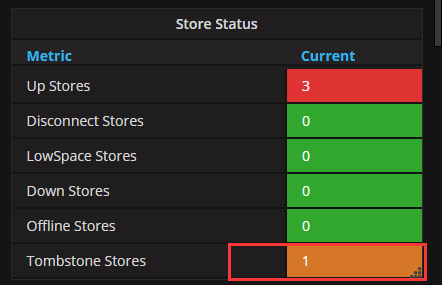

2、通过指令卸载169(需要缩容的节点)完成缩容操作后查询节点为:

首先你要从 pd 里面看 store 信息更准确一些,监控可能存在延迟的情况。 扩容成功后,现在 tikv 是几个节点? 另外原缩容节点的数据目录已经被删除,属于错误操作。

先用上面描述的命令将下线节点的状态从 offline 变成 tombstone,然后再将节点从集群中踢出。先确保缩容操作完全踢出。然后再去进行加节点的扩容操作。

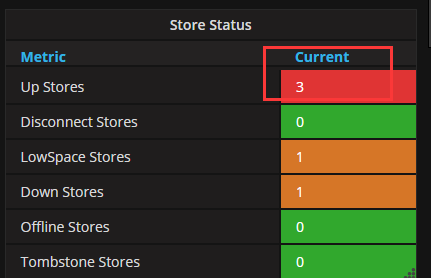

通过查看PD的监控可以看到store为3个

运行上面的指令直接剔除169节点返回null

但是在滚动升级后发现节点并没有消失,查看监控节点内容为

是否可以执行挂载操作重新挂载节点,完成节点服务的重新上线?

是否从 扩容 节点再把节点 缩容 有时间限制?

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。