变量名称应该是相同的嘛,value不同,如下:

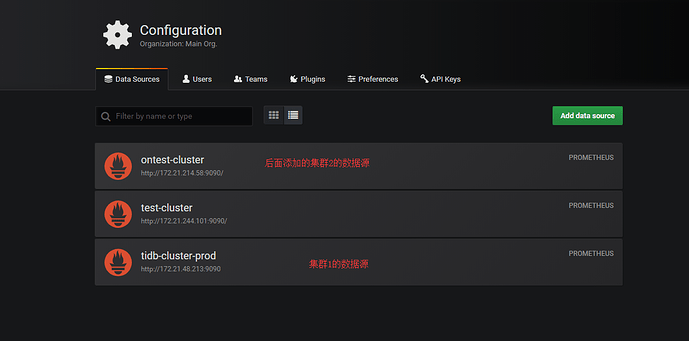

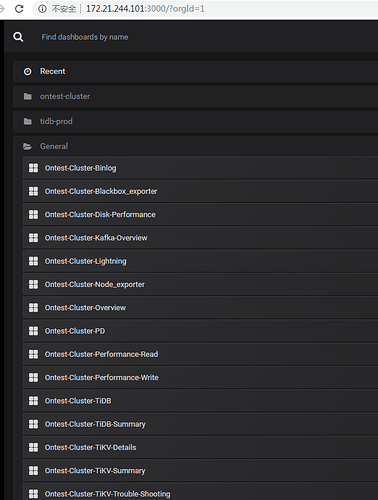

[{“apikey”: “eyJrIjoiR3R5aVAwWTRqckVPZDdRWWVtd2YzcG02NXV0NVhnTVciLCJuIjoiZ3JhZmFuYV9hcGlrZXkiLCJpZCI6MX0=”, “name”: “Ontest-Cluster”, “url”: “http://172.21.244.101:3000/”, “titles”: {“node”: “Ontest-Cluster-Node_exporter”, “binlog”: “Ontest-Cluster-Binlog”, “tikv_summary”: “Ontest-Cluster-TiKV-Summary”, “performance_read”: “Ontest-Cluster-Performance-Read”, “tidb_summary”: “Ontest-Cluster-TiDB-Summary”, “overview”: “Ontest-Cluster-Overview”, “performance_write”: “Ontest-Cluster-Performance-Write”, “disk_performance”: “Ontest-Cluster-Disk-Performance”, “tikv_details”: “Ontest-Cluster-TiKV-Details”, “lightning”: “Ontest-Cluster-Lightning”, “tikv_trouble_shot”: “Ontest-Cluster-TiKV-Trouble-Shooting”, “blackbox_exporter”: “Ontest-Cluster-Blackbox_exporter”, “pd”: “Ontest-Cluster-PD”, “tidb”: “Ontest-Cluster-TiDB”, “kafka_overview”: “Ontest-Cluster-Kafka-Overview”}, “user”: “admin”, “password”: “xxxx”, “datasource”: “ontest-cluster”}]

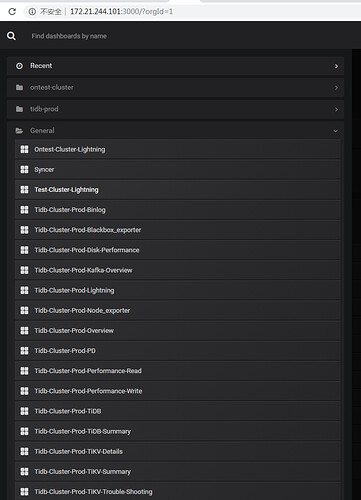

[{“apikey”: “eyJrIjoiWUl2cVdjZ0VVQ0pod2pTNVZ5QzhpUW53WWVJVld0cVYiLCJuIjoiZ3JhZmFuYV9hcGlrZXkiLCJpZCI6MX0=”, “name”: “Tidb-Cluster-Prod”, “url”: “http://172.21.244.101:3000/”, “titles”: {“node”: “Tidb-Cluster-Prod-Node_exporter”, “binlog”: “Tidb-Cluster-Prod-Binlog”, “tikv_summary”: “Tidb-Cluster-Prod-TiKV-Summary”, “performance_read”: “Tidb-Cluster-Prod-Performance-Read”, “tidb_summary”: “Tidb-Cluster-Prod-TiDB-Summary”, “overview”: “Tidb-Cluster-Prod-Overview”, “performance_write”: “Tidb-Cluster-Prod-Performance-Write”, “disk_performance”: “Tidb-Cluster-Prod-Disk-Performance”, “tikv_details”: “Tidb-Cluster-Prod-TiKV-Details”, “lightning”: “Tidb-Cluster-Prod-Lightning”, “tikv_trouble_shot”: “Tidb-Cluster-Prod-TiKV-Trouble-Shooting”, “blackbox_exporter”: “Tidb-Cluster-Prod-Blackbox_exporter”, “pd”: “Tidb-Cluster-Prod-PD”, “tidb”: “Tidb-Cluster-Prod-TiDB”, “kafka_overview”: “Tidb-Cluster-Prod-Kafka-Overview”}, “user”: “admin”, “password”: “xxx”, “datasource”: “tidb-cluster-prod”}]