浪矢解忧杂货铺

(浪矢解忧杂货铺)

1

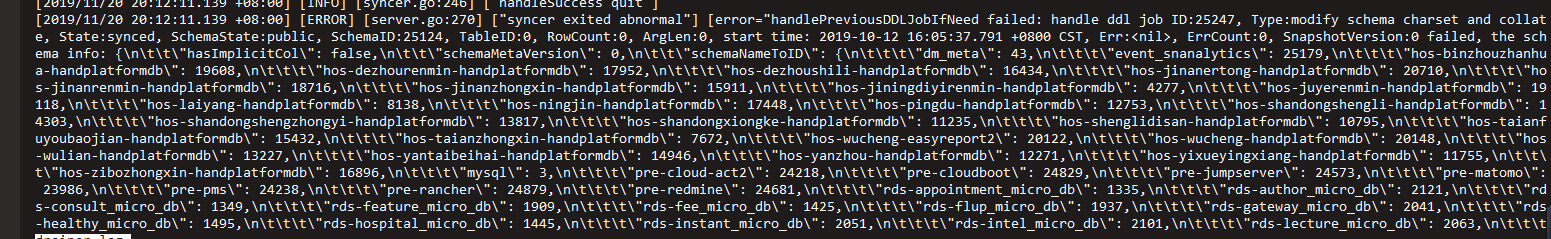

为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:

系统版本 & kernel 版本: Linux tidb-dm-worker-131 3.10.0-957.el7.x86_64 #1 SMP Thu Nov 8 23:39:32 UTC 2018 x86_64 x86_64 x86_64 GNU/Linux

TiDB 版本:3.0.2

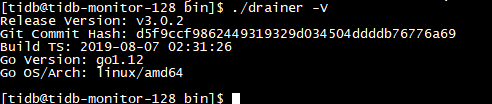

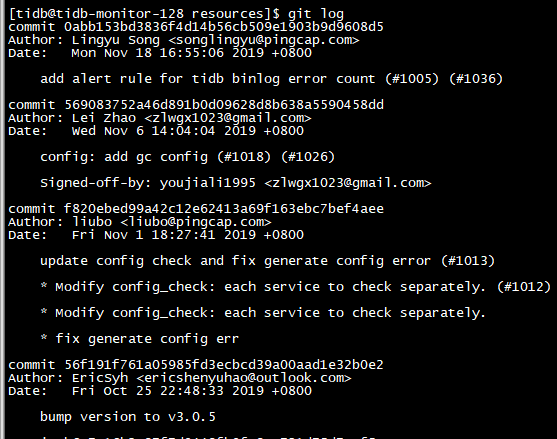

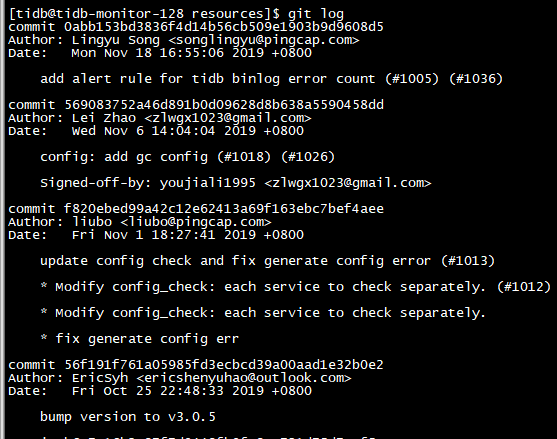

TiDB binlog版本,目前是3.0.5

磁盘型号:机械硬盘

- 【问题描述】:

目前用 tidb集群binlog已经开启,在 Drainer往kafka吐数据的时候出现这个问题。目前Pump的状态是好的, tidb的版本下图 ,昨天刚升级了binlog集群,目前是3.0.5 ,目前是正式生产环境,请帮帮忙解决一下,也是刚接手的,不太明白,最好能跟我讲的细致一点,谢谢谢谢。请跟帖的时候多跟进一下,我会一直在线等的。谢谢

,目前是正式生产环境,请帮帮忙解决一下,也是刚接手的,不太明白,最好能跟我讲的细致一点,谢谢谢谢。请跟帖的时候多跟进一下,我会一直在线等的。谢谢

若提问为性能优化、故障排查类问题,请下载脚本运行。全选终端打印结果,并复制粘贴上传。

浪矢解忧杂货铺

(浪矢解忧杂货铺)

2

我知道我说的不清楚,如果有什么问题想看什么地方,我在给你们截图。谢谢,万分感谢。我会一直在线等的。

QBin

(Bin)

4

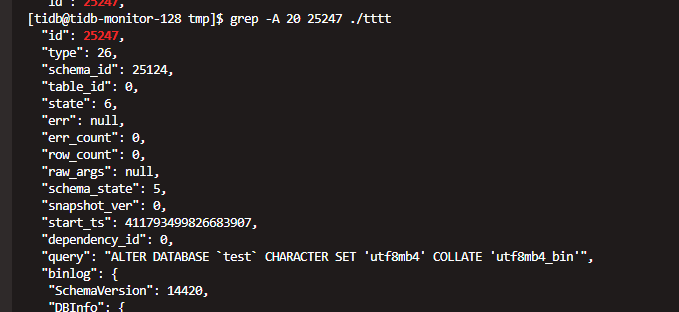

执行下 “curl http://{TiDBIP}:{tidb_status_port}/ddl/history” 。然后看下 ddl job id 是 25247 的是什么 SQL 。

浪矢解忧杂货铺

(浪矢解忧杂货铺)

6

不好意思,要多多麻烦你了,刚接手这个东西。还不是很熟悉。谢谢您。多关注着我这个帖子点,谢谢您,谢谢您。

QBin

(Bin)

10

端口错了。是 tidb_status_port ,默认是 10080。具体要看下 tidb-ansible 目录下面的 inventory.ini 文件里面配置的是什么。

浪矢解忧杂货铺

(浪矢解忧杂货铺)

11

执行了之后疯狂的在打日志,根本看不到。这时候应该怎么办?

浪矢解忧杂货铺

(浪矢解忧杂货铺)

12

您好,我之前的都不想要了,我怎么能让它从当前时间的binlog在重新往下吐?就相当于从现在开始之前的binlog我全部都不要了。

浪矢解忧杂货铺

(浪矢解忧杂货铺)

15

可是我不知道怎么能导出来给你看。实在不行,我想之前的binlog我们都不要了,重新从当前时间开始往下吐,跳过当前时间之前的所有

浪矢解忧杂货铺

(浪矢解忧杂货铺)

17

你好,能不能跳过去之前的这些,我想直接从当前时间开始。之前的我都不要了。行吗

,目前是正式生产环境,请帮帮忙解决一下,也是刚接手的,不太明白,最好能跟我讲的细致一点,谢谢谢谢。请跟帖的时候多跟进一下,我会一直在线等的。谢谢

,目前是正式生产环境,请帮帮忙解决一下,也是刚接手的,不太明白,最好能跟我讲的细致一点,谢谢谢谢。请跟帖的时候多跟进一下,我会一直在线等的。谢谢